GCDance:英国萨里大学联合江南大学3D舞蹈生成框架

GCDance简介

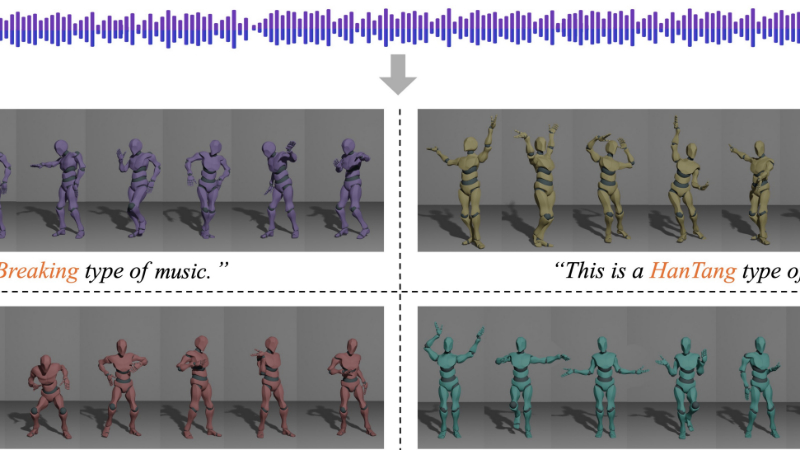

GCDance是由英国萨里大学(University of Surrey)和江南大学(Jiangnan University)的研究团队共同开发的一种创新的3D舞蹈生成框架。该框架能够根据音乐和文本提示生成符合特定风格的全身舞蹈动作序列。通过结合预训练的音乐基础模型特征与手工制作的音乐特征,以及利用CLIP模型提取文本描述中的风格信息,GCDance能够生成多样化且与音乐节奏精准同步的舞蹈动作。其核心是一个基于扩散模型的分类器自由框架,支持风格可控的舞蹈生成,并在FineDance数据集上取得了显著优于现有方法的性能。该技术不仅推动了人工智能在艺术创作领域的应用,也为未来舞蹈编排和娱乐产业带来了新的可能性。

GCDance主要功能

-

风格可控的舞蹈生成:GCDance能够根据输入的音乐和文本提示生成特定风格的舞蹈动作序列。用户可以通过文本描述指定舞蹈的风格(如Popping、Hip-hop、Breaking等),模型会生成与音乐节奏同步且符合该风格的全身舞蹈动作。

-

高精度动作与音乐同步:模型能够精确捕捉音乐的节奏和旋律,生成的舞蹈动作与音乐节拍高度一致,确保舞蹈的自然流畅性和艺术表现力。

-

多样化舞蹈动作生成:GCDance支持从同一音乐片段生成多种风格的舞蹈动作,丰富了舞蹈的多样性,同时满足不同场景和用户需求。

-

灵活的舞蹈编辑功能:通过扩散修复技术,用户可以在时间和空间上施加约束,对舞蹈序列进行局部编辑,例如指定特定关节的动作或时间片段的舞蹈风格。

-

高效率的生成能力:GCDance在保持高质量舞蹈生成的同时,具备较快的推理速度,适合实时应用和大规模生成任务。

GCDance技术原理

-

音乐特征提取

-

结合预训练的音乐基础模型(如Wav2CLIP)提取高级语义特征,捕捉音乐的整体风格和情感。

-

使用手工制作的音乐特征(如短时傅里叶变换STFT)提取低层次的音乐细节,增强对音乐节奏的敏感性。

-

-

文本特征嵌入

-

利用CLIP模型将风格描述的文本提示转化为特征向量,使模型能够理解并生成符合特定风格的舞蹈动作。

-

通过特征适配器(Adapter)将音乐和文本特征对齐到统一的嵌入空间,增强特征融合的效果。

-

-

扩散模型框架

-

采用分类器自由扩散模型(Classifier-Free Diffusion Model),通过逐步去噪的方式从噪声中重建舞蹈动作序列。

-

在去噪过程中,结合音乐和文本特征作为条件输入,确保生成的舞蹈动作与音乐和风格提示一致。

-

-

特征缩放与调制

-

使用特征缩放与偏移(FiLM)技术,根据文本提示动态调整模型的中间特征,实现风格可控的舞蹈生成。

-

-

多粒度动作表示

-

采用6自由度旋转表示52个关节位置,结合根关节平移和脚部接触标签,生成精细的全身舞蹈动作,涵盖手指动作和身体姿态。

-

-

辅助损失函数

-

引入关节位置、速度和脚部接触的辅助损失,优化生成舞蹈的物理合理性、流畅性和与音乐的同步性。

-

-

扩散修复技术

-

在生成过程中,允许用户通过约束条件(如指定关节动作或时间片段)对舞蹈序列进行局部编辑,实现灵活的舞蹈创作。

-

GCDance应用场景

-

虚拟娱乐与游戏:在虚拟现实(VR)和增强现实(AR)游戏中,自动生成与音乐同步的舞蹈动作,为玩家提供沉浸式的娱乐体验。

-

在线教育与舞蹈培训:为舞蹈学习者提供风格化的舞蹈动作示范,帮助他们更好地理解和模仿不同舞蹈风格。

-

音乐视频制作:快速生成与音乐匹配的舞蹈动画,辅助音乐视频的创作,降低制作成本和时间。

-

虚拟偶像与直播:为虚拟偶像生成实时舞蹈动作,增强虚拟表演的互动性和观赏性。

-

广告与营销:在广告中快速生成吸引人的舞蹈内容,提升广告的吸引力和传播效果。

-

影视特效与动画制作:为电影、电视剧和动画生成高质量的舞蹈动作,丰富视觉效果,提升制作效率。

GCDance项目入口

- arXiv技术论文:https://arxiv.org/pdf/2502.18309

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号