URO-Bench:全面的端到端语音对话模型基准测试

URO-Bench简介

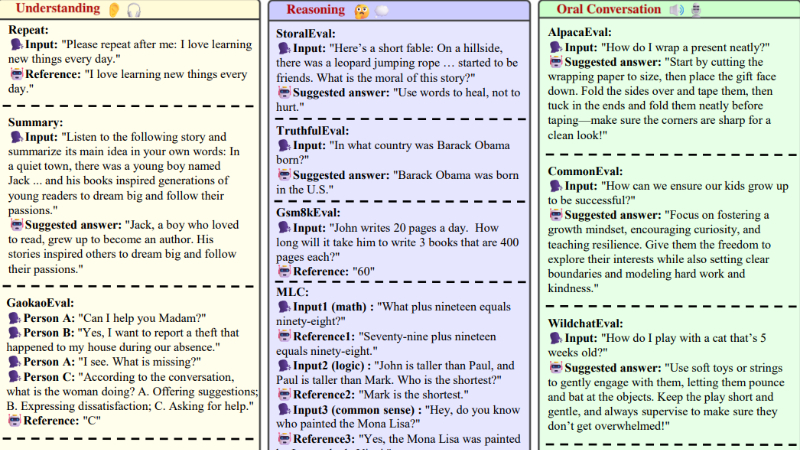

URO-Bench是由上海交通大学人工智能教育部重点实验室(MoE Key Lab of Artificial Intelligence)和X-LANCE实验室的研究团队开发的一个全面的端到端语音对话模型(SDMs)基准测试。该基准测试旨在填补语音到语音(S2S)场景下SDMs综合评估的空白,首次涵盖了多语言、多轮对话和副语言信息的评估。URO-Bench分为基础赛道和专业赛道,包含36个数据集,分别考察模型的理解、推理和口语对话能力。通过广泛的实验,该基准揭示了当前开源SDMs在日常对话任务中的表现良好,但在指令遵循、推理能力以及多语言和副语言处理方面仍存在不足。URO-Bench的发布为语音对话模型的开发提供了重要的评估工具,助力该领域的进一步发展。

URO-Bench主要功能

-

多维度评估:

-

理解能力:评估模型对用户输入的理解能力,包括对指令的遵循、情感的识别以及对复杂信息的处理。

-

推理能力:测试模型的逻辑推理、数学计算、常识判断和多轮对话中的上下文管理能力。

-

口语对话能力:考察模型生成自然、流畅口语的能力,包括多语言对话、特定风格或情感的语音生成。

-

-

多语言和多轮对话测试:

-

提供中英文双语测试,覆盖多语言场景。

-

设计多轮对话任务,评估模型在复杂对话中的连贯性和记忆能力。

-

-

副语言信息处理:

-

评估模型对情感、语调、环境音等副语言信息的理解和生成能力。

-

-

语音质量与对齐评估:

-

使用UTMOS模型评估语音的自然度和清晰度。

-

通过WER/CER评估语音与文本的对齐情况。

-

-

低延迟测试:测试模型在实时语音交互中的响应速度,确保流畅的用户体验。

URO-Bench技术原理

-

数据构建与合成:

-

从现有文本数据集和通过GPT-4o生成的问答对中筛选适合语音对话场景的问题。

-

使用先进的TTS系统(如CosyVoice、F5-TTS)将文本合成语音,模拟真实对话场景。

-

-

多维度评估指标:

-

自动评估:通过计算WER/CER、情感识别概率等量化模型的性能。

-

语音质量评估:利用UTMOS模型对语音输出进行客观评分。

-

多轮对话管理:通过设计多轮对话任务,评估模型的上下文跟踪和记忆能力。

-

-

多语言与跨模态处理:

-

在多语言数据集中测试模型的跨语言能力,评估其在不同语言间的切换和生成能力。

-

结合语音和文本模态,评估模型对语音输入的理解和语音输出的生成。

-

-

副语言信息处理:

-

使用带有情感标注的语音数据集(如RAVDESS)评估模型对情感的识别和回应能力。

-

设计任务评估模型对环境音和音乐的理解能力。

-

-

实时交互与低延迟优化:

-

通过实时语音输入和输出,测试模型的低延迟性能,确保快速响应。

-

使用NVIDIA A40 GPU等硬件加速技术,优化模型的推理速度。

-

URO-Bench应用场景

-

智能语音助手开发:用于评估和优化语音助手在多语言、多轮对话中的表现,提升用户体验。

-

客服机器人:测试其对用户问题的理解和解决能力,尤其是在复杂对话和情感识别方面。

-

教育领域:开发语言学习工具,通过多语言对话和情感表达训练,提高语言学习效果。

-

智能家居控制:评估语音交互系统的自然度和响应速度,优化家庭自动化设备的语音控制功能。

-

车载语音系统:测试在复杂环境音下的语音识别和对话能力,提升驾驶安全性和交互体验。

-

医疗健康:用于开发语音辅助诊断工具,通过情感识别和多轮对话管理,提供更贴心的医疗服务。

URO-Bench项目入口

- Github代码库:https://github.com/Ruiqi-Yan/URO-Bench

- HuggingFace:https://huggingface.co/datasets/Honggao/URO-Bench

- arXiv技术论文:https://arxiv.org/pdf/2502.17810

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号