IMAGPose:南京理工大学推出的姿态引导的人物图像生成框架

IMAGPose简介

IMAGPose是由南京理工大学团队提出的一种姿态引导的人物图像生成框架,旨在解决现有方法在多目标图像生成和多视角源图像生成方面的局限性。该框架通过融合特征级条件(FLC)、图像级条件(ILC)和跨视图注意力(CVA)三个核心模块,实现了高保真度和高一致性的目标图像生成。FLC模块结合低级纹理特征和高级语义特征,解决了细节丢失问题;ILC模块通过掩码策略适应多样化用户场景;CVA模块则确保全局一致性和局部保真度。IMAGPose在多个数据集上展现出卓越性能,为虚拟现实、影视制作和电子商务等领域提供了强大的技术支持。

IMAGPose主要功能

-

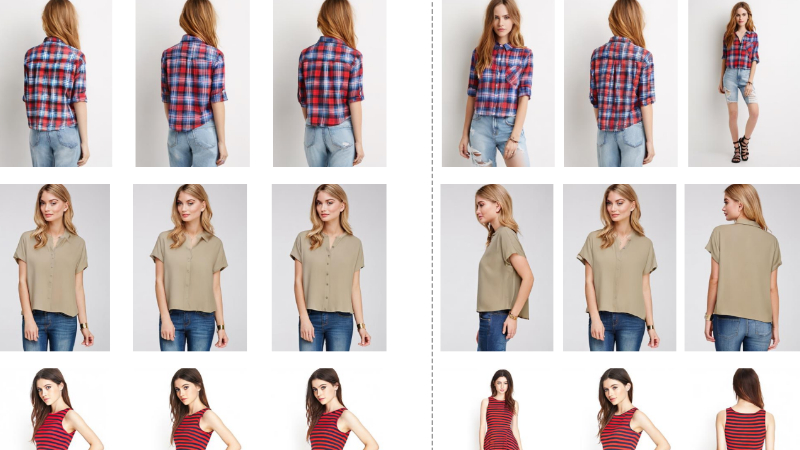

多目标图像生成:支持同时生成多个具有不同姿态的目标人物图像,满足用户在批量生成场景下的需求,例如虚拟试衣、动画制作等。

-

多视角源图像生成:能够利用多视角源图像生成目标图像,为用户提供更丰富的细节和更灵活的生成方式。

-

高保真度图像生成:通过融合低级纹理特征和高级语义特征,生成具有高一致性和逼真度的人物图像,适用于虚拟现实、影视制作等领域。

-

适应多样化用户场景:通过图像级条件和掩码策略,适应不同用户需求,支持从单个源图像和目标姿态生成图像,以及从多个源图像和目标姿态生成图像。

-

提升下游任务性能:生成的图像可用于增强下游任务(如人物再识别)的性能,扩展了其应用场景。

IMAGPose技术原理

-

特征级条件(FLC)模块:

-

结合VAE编码器提取的低级纹理特征和图像编码器提取的高级语义特征,解决现有方法因缺乏专用人物图像特征提取器而导致的细节丢失问题。

-

通过可训练的Tokenizer层将低级特征与高级特征融合,为生成过程提供更丰富的细节信息。

-

-

图像级条件(ILC)模块:

-

引入掩码策略,将多个目标图像或源图像组合成联合图像,并通过掩码区分生成区域和已知区域。

-

支持灵活注入不同数量的源图像条件,实现图像和姿态的一一对应,适应多样化的用户场景。

-

-

跨视图注意力(CVA)模块:

-

分解全局和局部交叉注意力,确保在多视角源图像提示下生成的人物图像具有局部保真度和全局一致性。

-

通过自注意力机制捕捉人物图像不同部分之间的关系,提升生成图像的整体质量。

-

-

扩散模型框架:

-

基于扩散模型的多步去噪过程,通过逐步去除噪声生成高质量图像,相比GAN方法具有更好的稳定性和细节保留能力。

-

使用分类器自由引导(classifier-free guidance)技术,进一步提升生成图像的质量和可控性。

-

-

统一条件框架:

-

将特征级、图像级条件和跨视图注意力模块有机结合,形成统一的条件框架,支持多种用户场景下的图像生成任务。

-

通过一次训练即可适应多种生成需求,无需针对不同场景切换模型,提升了用户体验和效率。

-

IMAGPose应用场景

-

虚拟试衣:通过生成不同姿态的人物图像,展示服装在各种动作下的效果,提升购物体验。

-

影视制作:快速生成人物角色的多种姿态和动作,辅助动画设计和特效制作,节省时间和成本。

-

虚拟现实(VR):为虚拟环境中的角色生成逼真的动态图像,增强沉浸感。

-

电子商务:为线上服装和配饰展示提供多样化的人物姿态图像,提升产品吸引力。

-

游戏开发:生成游戏角色的多种姿态和动作,丰富游戏场景和角色表现力。

-

人物再识别:通过生成多样化的人物图像,增强下游任务(如监控系统中的人物识别)的性能和鲁棒性。

IMAGPose项目入口

- Github代码库:https://github.com/muzishen/IMAGPose

- 技术论文:https://openreview.net/pdf

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号