R1-Omni简介

R1-Omni是由阿里巴巴集团通义实验室开发的一种创新的全模态情感识别模型。该模型首次将强化学习与可验证奖励(RLVR)技术应用于多模态大语言模型,专注于情感识别任务。通过结合视觉和音频模态信息,R1-Omni显著提升了推理能力、情感识别准确性和模型泛化能力。开发团队利用独特的冷启动策略和群组相对策略优化(GRPO)方法,使模型在分布内和分布外数据上均展现出卓越性能。R1-Omni不仅为情感识别领域带来了新的技术突破,还为多模态大语言模型的优化提供了新的思路和方向。

R1-Omni主要功能

-

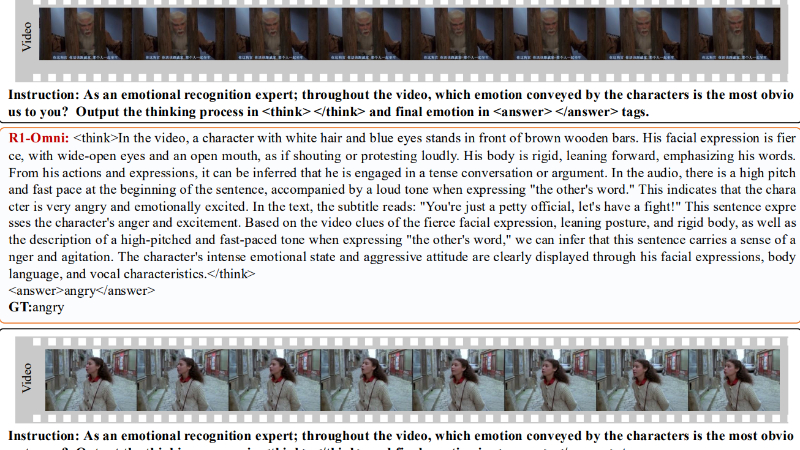

情感识别:能够准确识别视频中人物所表达的情感,支持多种情感类别(如愤怒、快乐、惊讶等),并输出情感标签。

-

可解释推理:生成详细的推理过程,解释视觉和音频信息如何共同影响情感预测,提供清晰的决策逻辑。

-

多模态融合:整合视频中的视觉信息(如面部表情、肢体语言)和音频信息(如语调、节奏),实现更全面的情感分析。

-

泛化能力:在未见过的数据分布上表现出色,能够适应多样化的场景和数据类型,增强了模型的实用性。

-

结构化输出:以HTML-like的标签格式输出推理过程和情感结果,便于后续处理和分析。

R1-Omni技术原理

-

强化学习与可验证奖励(RLVR):

-

使用RLVR优化模型,通过验证函数直接评估输出的正确性,无需额外的奖励模型。

-

奖励函数由准确性奖励(Racc)和格式奖励(Rformat)组成,确保模型输出既准确又符合结构要求。

-

通过最大化奖励和保持与参考模型的接近性(通过KL散度正则化),优化模型性能。

-

-

群组相对策略优化(GRPO):

-

生成多个候选响应,并通过标准化奖励分数评估其相对质量。

-

无需额外的批评模型,直接比较同一组内不同响应的优劣,提高模型对高质量输出的识别能力。

-

-

冷启动策略:

-

使用EMER数据集进行预训练,使模型初步具备推理能力。

-

结合少量手动标注数据,为后续的RLVR训练奠定基础。

-

-

多模态输入处理:

-

模型接收视频帧和音频流作为输入,通过融合视觉和音频信息进行情感预测。

-

视觉信息包括人物表情、肢体动作等,音频信息包括语调、节奏和语速等。

-

-

结构化输出与评估:

-

输出包含推理过程(<think>标签)和情感标签(<answer>标签),便于分析和验证。

-

使用未加权平均召回率(UAR)和加权平均召回率(WAR)等指标评估模型性能。

-

R1-Omni应用场景

-

智能客服:实时分析客户语音或视频通话中的情绪,帮助客服人员及时调整服务策略,提升客户满意度。

-

心理健康监测:通过分析患者的表情和语音,辅助心理医生评估情绪状态,为诊断和治疗提供参考。

-

智能教育:监测学生在课堂上的情绪反应,帮助教师调整教学方法,提高教学效果。

-

影视内容分析:分析影视作品中角色的情感表达,辅助影视制作团队优化剧本和表演。

-

广告效果评估:评估观众对广告内容的情绪反应,帮助广告商优化广告策略,提高投放效果。

-

智能安防监控:在公共场所监测人群情绪,及时发现异常情绪波动,预防潜在的安全风险。

R1-Omni项目入口

- Github代码库:https://github.com/HumanMLLM/R1-Omni

- HuggingFace:https://huggingface.co/StarJiaxing/R1-Omni-0.5B

- arXiv技术论文:https://arxiv.org/pdf/2503.05379

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号