GAUSSIANANYTHING:南洋理工大学等推出的3D 生成框架

GAUSSIANANYTHING简介

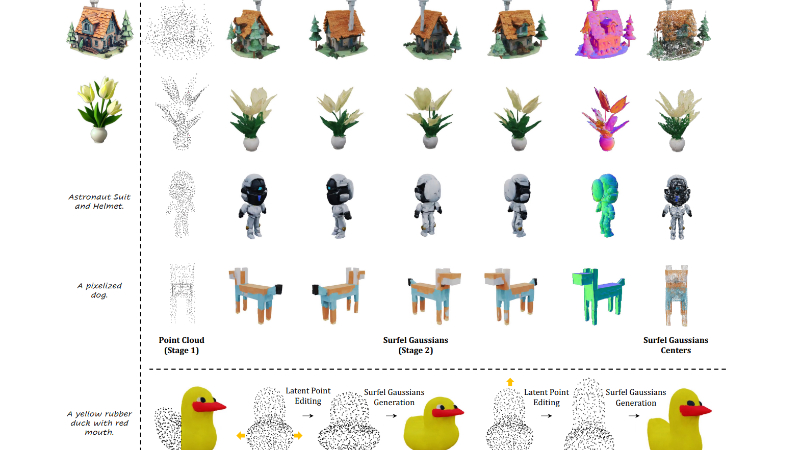

GAUSSIANANYTHING 是由南洋理工大学 S-Lab、上海人工智能实验室和北京大学联合开发的新型 3D 生成框架。该框架通过创新的点云结构化潜在空间设计,结合多视图 RGB-D-N 渲染输入和级联扩散模型,实现了高质量、可编辑的 3D 内容生成。它支持多种输入模态,包括点云、文本和图像,能够生成具有高保真纹理和几何细节的 3D 对象。GAUSSIANANYTHING 在文本和图像条件下的 3D 生成任务中表现出色,超越了现有方法,并为 3D 内容创作和编辑提供了新的可能性。

GAUSSIANANYTHING主要功能

-

高质量3D生成:能够从单视图图像、文本描述或点云输入生成高质量的3D对象,支持复杂的几何结构和纹理细节。

-

多模态输入支持:兼容多种输入格式,包括点云、文本和单/多视图图像,满足不同场景下的3D生成需求。

-

交互式3D编辑:通过点云结构化的潜在空间,用户可以直接在潜在空间中进行3D对象的编辑,实现几何结构和纹理的灵活调整。

-

高效的渲染输出:生成的3D对象以surfel Gaussians(表面高斯分布)形式表示,支持高效渲染,适合实时应用和高分辨率输出。

GAUSSIANANYTHING技术原理

-

点云结构化潜在空间:

-

通过将3D对象编码为点云结构化的潜在空间,实现几何与纹理的解耦,便于后续的3D编辑和生成。

-

利用稀疏点云采样和交叉注意力机制,将无序的特征编码为有序的点云结构,提升潜在空间的可编辑性。

-

-

多视图RGB-D-N渲染输入:

-

使用多视图的RGB(颜色)、D(深度)和N(法线)渲染作为输入,相比单一的点云或图像输入,能够更全面地捕捉3D对象的几何和纹理信息。

-

通过场景表示变换器(Scene Representation Transformer)处理多视图输入,确保3D一致性并减少视图间的信息丢失。

-

-

级联扩散模型:

-

采用两阶段扩散模型:首先生成稀疏点云以确定3D对象的整体布局,然后生成对应的点云特征以细化纹理和细节。

-

使用流匹配(Flow Matching)技术训练扩散模型,提升生成质量和效率。

-

-

Surfel Gaussians输出表示:

-

将生成的3D对象以surfel Gaussians(表面高斯分布)形式表示,支持高效的渲染和高质量的表面建模。

-

通过级联上采样模块,逐步将稀疏点云细化为密集的高斯分布,提升渲染分辨率和质量。

-

-

交互式编辑支持:

-

点云结构化的潜在空间允许用户直接对3D对象的几何结构进行编辑,编辑后的结果可以通过扩散模型重新生成,实现灵活的3D内容创作。

-

支持基于文本或图像的条件生成和编辑,进一步扩展了3D生成的应用场景。

-

GAUSSIANANYTHING应用场景

-

3D内容创作:快速生成高质量的3D模型,用于游戏开发、影视特效、虚拟现实等领域,提升创作效率。

-

虚拟现实与增强现实:根据用户输入(如文字描述或图像)实时生成3D场景或物体,增强沉浸感和交互性。

-

工业设计与产品展示:根据设计概念或草图快速生成3D产品原型,用于虚拟展示和设计迭代。

-

文化遗产保护:通过文字或图像描述,重建历史文物或古迹的3D模型,用于数字化保护和展示。

-

教育与培训:生成3D教学模型,帮助学生更直观地理解复杂的科学概念或历史场景。

-

电商与在线购物:根据商品描述或用户上传的图片生成3D商品模型,提升购物体验,减少因视觉差异导致的退货率。

GAUSSIANANYTHING项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号