VACE:阿里通义推出的的视频生成与编辑框架

VACE简介

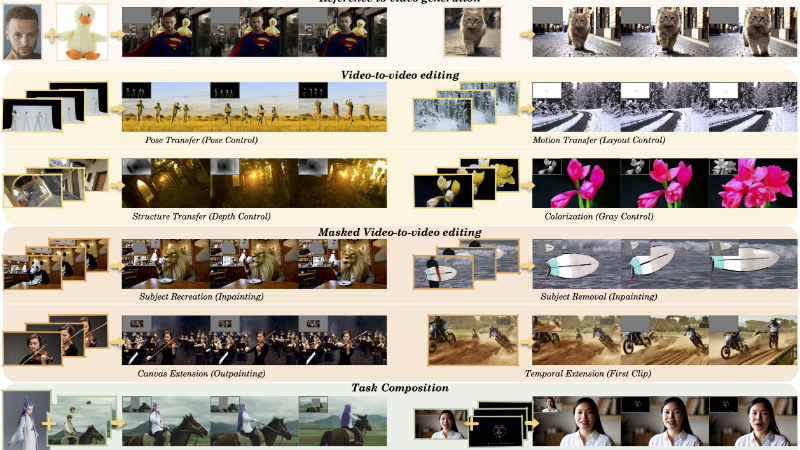

VACE(Video All-in-One Creation and Editing)是由阿里巴巴集团通义实验室开发的视频生成与编辑框架。它基于扩散变换器(Diffusion Transformer)架构,通过整合文本、图像、视频和掩码等多种输入模态,实现了从文本到视频生成、参考视频生成、视频编辑到复杂任务组合的多功能视频创作。VACE通过创新的视频条件单元(VCU)和上下文适配器(Context Adapter)结构,将多种视频任务统一到一个框架中,显著降低了部署成本并提升了创作灵活性。该框架在多种任务上展现出与专门模型相当的性能,同时支持复杂任务组合,为视频内容创作开辟了新可能性。

VACE主要功能

-

多任务视频生成与编辑:

-

支持从文本到视频(T2V)的生成,能够根据文本描述直接生成视频内容。

-

实现参考到视频(R2V)的生成,可根据提供的图像或视频帧作为参考生成符合要求的视频。

-

提供视频到视频(V2V)编辑功能,能够对输入视频进行风格化、上色、姿态调整等整体修改。

-

支持掩码视频到视频(MV2V)编辑,通过掩码指定编辑区域,实现视频中的局部修复、扩展和替换。

-

支持任务组合,用户可以自由组合上述功能,完成复杂的视频创作需求,例如参考特定对象进行视频修复或扩展。

-

-

高效的内容创作支持:

-

提供高质量的视频生成与编辑,支持多种分辨率和帧率的输入与输出。

-

通过灵活的任务组合,能够实现长视频的重新渲染和创意生成,满足广告、影视、动画等多种行业的创作需求。

-

-

用户友好与高效部署:

-

提供统一的视频条件单元(VCU)接口,简化了多模态输入的复杂性,降低了用户使用门槛。

-

通过Context Adapter结构,能够快速适配不同任务,减少了模型训练和部署的时间与资源成本。

-

VACE技术原理

-

视频条件单元(VCU):

-

VCU是VACE的核心输入接口,将文本、视频帧、掩码等多种模态信息整合为统一的输入格式。

-

通过VCU,模型能够灵活处理不同任务的需求,例如在R2V任务中添加参考帧,在MV2V任务中指定掩码区域。

-

-

Context Adapter结构:

-

Context Adapter通过插件式的方式将不同任务的概念注入模型中,使得模型能够根据任务需求动态调整生成策略。

-

该结构支持快速适配多种任务,避免了对基础模型的全量微调,提高了模型的灵活性和训练效率。

-

-

扩散变换器(DiT)架构:

-

VACE基于DiT架构,利用其强大的生成能力和可扩展性,支持高质量视频的生成与编辑。

-

通过优化DiT模型的输入和训练策略,VACE能够高效处理长视频序列,并保持时空一致性。

-

-

多模态输入的整合与处理:

-

VACE通过“概念解耦”策略,将自然视频与控制信号(如深度图、姿态图)分离,避免不同模态信息之间的冲突。

-

利用视频VAE和掩码编码器,将输入的视频帧和掩码映射到高维特征空间,确保生成过程中的时空一致性。

-

-

数据集与训练策略:

-

VACE构建了包含多种任务的数据集,涵盖文本到视频、修复、扩展、深度控制等多种场景。

-

采用分阶段训练策略,逐步扩展模型的任务能力,最终通过高质量数据微调,提升模型的生成质量。

-

VACE应用场景

VACE项目入口

- 项目主页:https://ali-vilab.github.io/VACE-Page

- GitHub代码库:https://github.com/ali-vilab/VACE

- arXiv技术论文:https://arxiv.org/pdf/2503.07598

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号