PE3R:新加坡国立大学推出的高效3D重建框架

PE3R简介

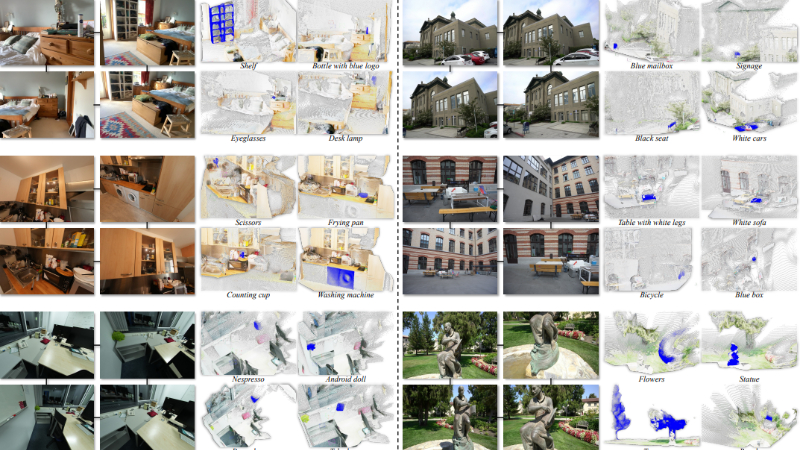

PE3R(Perception-Efficient 3D Reconstruction)是由新加坡国立大学1xML实验室开发的一种高效3D重建框架,旨在通过2D图像实现快速且准确的3D场景语义重建。该框架通过像素嵌入消歧、语义场重建和全局视图感知三大模块,解决了现有方法在泛化能力、感知精度和重建速度上的不足。PE3R能够在无需额外3D数据(如相机参数或深度信息)的情况下,仅依靠2D图像完成高质量的3D重建,并支持通过自然语言进行语义交互。实验表明,PE3R在多个数据集上实现了显著的性能提升,重建速度比现有方法快9倍,同时在语义分割和重建精度上也表现出色,为2D到3D感知领域树立了新的基准。

PE3R主要功能

-

高效3D语义重建:PE3R能够从2D图像中快速重建出3D场景的语义信息,无需额外的3D数据(如深度图或相机参数),显著降低了数据获取成本。

-

零样本泛化能力:该框架支持对未见过的场景和物体进行鲁棒的语义重建,无需针对每个场景进行特定训练,提升了模型的通用性。

-

语义交互功能:PE3R支持通过自然语言查询定位和识别3D场景中的语义目标,例如通过“红色椅子”等描述直接在重建场景中找到对应对象。

-

实时性与可扩展性:PE3R的重建速度比现有方法快9倍,能够支持大规模场景的实时处理,适用于需要快速响应的应用场景。

PE3R技术原理

-

像素嵌入消歧(Pixel Embedding Disambiguation)

-

多视角语义一致性:通过多视角的语义信息解决像素级别的歧义,确保不同视角下的语义一致性。

-

面积加权聚合:结合对象的面积信息,对图像嵌入进行加权聚合,保留小对象的语义信息,避免语义丢失。

-

跨视角跟踪:利用分割模型(如SAM2)为多视角图像中的对象分配一致的标签,增强语义信息的连贯性。

-

-

语义场重建(Semantic Field Reconstruction)

-

语义引导的点云细化:将语义信息直接嵌入到3D重建过程中,通过语义引导的细化提高点云的精度。

-

异常点检测与过滤:利用语义掩码平滑输入图像,减少反射、透明度和遮挡带来的噪声点。

-

全局对齐:对齐不同视角的点云,确保重建场景的几何一致性。

-

-

全局视图感知(Global View Perception)

-

文本与点云匹配:通过全局相似性归一化,将文本嵌入与3D点云嵌入进行匹配,实现基于自然语言的语义目标定位。

-

语义一致性增强:从全局视角出发,减少单视角噪声,提升对复杂场景的语义理解能力。

-

-

前馈架构(Feed-Forward Architecture)

-

快速点云预测:采用前馈模型(如DUSt3R)直接从2D图像预测3D点云,避免了传统方法中复杂的优化过程,显著提升了重建速度。

-

实时处理能力:支持大规模场景的实时重建,满足实际应用中对效率和精度的双重需求。

-

PE3R应用场景

-

自动驾驶:通过2D图像快速重建道路场景的3D语义信息,帮助车辆实时感知周围环境,提升自动驾驶的安全性和决策效率。

-

机器人导航:为机器人提供实时的3D场景重建和语义理解,使其能够更精准地识别目标物体并规划路径。

-

增强现实(AR):将2D图像转换为3D场景,为AR应用提供逼真的虚拟环境,增强用户体验。

-

文物保护:快速重建文物的3D模型,并通过语义标注辅助研究和修复工作。

-

建筑与室内设计:从2D图像重建室内或建筑场景,辅助设计规划和虚拟展示。

-

灾害救援:在复杂环境中快速重建3D场景,帮助救援人员快速了解现场情况,提高救援效率。

PE3R项目入口

- GitHub代码库:https://github.com/hujiecpp/PE3R

- arXiv研究论文:https://arxiv.org/pdf/2503.07507

- 在线体验:https://huggingface.co/spaces/hujiecpp/PE3R

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号