Motion Anything:悉尼大学等推出的多模态运动生成框架

Motion Anything简介

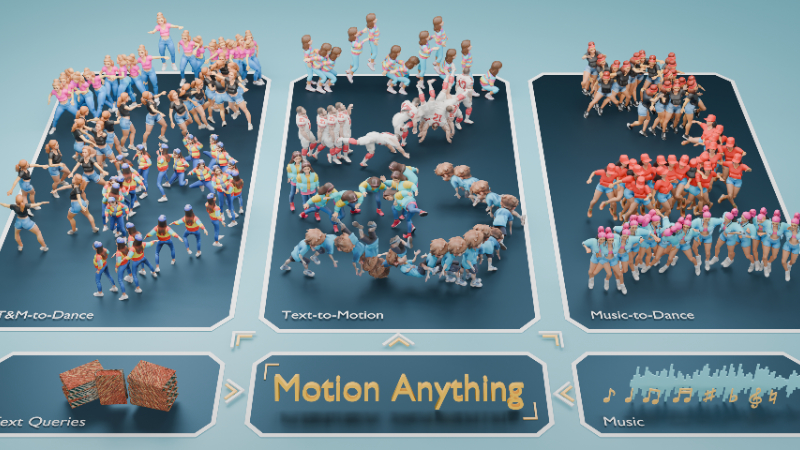

Motion Anything是由澳大利亚国立大学(ANU)、悉尼大学(USYD)、腾讯、麦吉尔大学(McGill)、京东(JD.com)、悉尼科技大学(UTS)、穆罕默德·本·扎耶德人工智能大学(MBZUAI)、浙江大学(ZJU)和谷歌(Google)联合组成的开发团队共同提出的一种多模态运动生成框架。该框架通过创新的基于注意力机制的掩码建模方法,能够在时空两个维度上对关键帧和动作进行细粒度控制,从而生成高质量、可控的人类运动序列。它能够自适应地整合文本、音乐等多种条件模态,显著提升了运动生成的可控性和连贯性。此外,开发团队还发布了Text-Music-Dance(TMD)数据集,为多模态运动生成的研究提供了新的基准。Motion Anything在多个基准测试中超越了现有最先进方法,为运动生成领域带来了突破性进展。

Motion Anything主要功能

-

多模态条件输入:支持多种输入模态,包括文本描述、背景音乐或两者的组合,能够根据输入条件生成高质量、可控的人类运动序列。

-

细粒度时空控制:通过注意力机制实现对运动序列中关键帧和关键动作的细粒度控制,优先生成动态帧和身体部位,提升生成运动的连贯性和可控性。

-

高质量运动生成:在多种基准数据集上表现出色,生成的运动序列具有高真实感、多样性和与条件的对齐性,适用于影视制作、游戏开发、虚拟现实等领域。

-

多模态数据集支持:提供了新的Text-Music-Dance(TMD)数据集,包含文本、音乐和舞蹈的配对样本,填补了多模态运动生成领域的数据空白,推动相关研究发展。

Motion Anything技术原理

-

基于注意力的掩码建模:利用注意力机制选择与条件最相关的运动序列部分进行掩码处理,通过掩码恢复任务学习关键帧和动作的动态特征,相比传统随机掩码方法更具针对性。

-

时空自适应变换器(TAT):在时间维度上对齐运动序列与条件模态(如文本或音乐),动态调整注意力计算,使运动的关键帧与文本描述或音乐节拍精准匹配。

-

空间对齐变换器(SAT):在空间维度上对齐运动序列与条件模态,将条件嵌入与运动特征重新排列,实现对特定身体部位动作的精细控制,提升运动的空间连贯性。

-

多模态条件编码与整合:自适应处理文本、音乐等多种条件模态,通过编码器将条件信息转化为特征嵌入,整合到运动生成过程中,增强生成运动的多样性和可控性。

-

自回归生成框架:采用自回归生成范式,结合掩码建模策略,逐步恢复被掩码的运动特征,生成连贯且符合条件的运动序列,同时保持高效的生成性能。

Motion Anything应用场景

-

影视制作:用于快速生成动画角色的动作,减少手工动画制作的时间和成本,同时可根据剧本描述或音乐节奏生成精准匹配的动态镜头。

-

视频游戏开发:实时生成角色动作,提升游戏的交互性和沉浸感。例如,根据游戏剧情文本或背景音乐生成NPC的动作或玩家角色的舞蹈。

-

虚拟现实(VR)与增强现实(AR):为虚拟场景中的角色或虚拟化身生成自然的运动,增强用户体验的真实感和互动性。

-

舞蹈编排与教学:根据音乐风格或舞蹈描述生成舞蹈动作,辅助编舞师进行创意探索,或为舞蹈学习者提供直观的动作示范。

-

人机交互与机器人控制:为机器人生成符合人类行为模式的动作,使其在与人类交互时表现得更加自然和友好。

-

在线教育与娱乐:生成与教学内容相关的动画,提升教学趣味性;或在娱乐应用中根据用户输入生成个性化舞蹈或动画,增加用户参与度。

Motion Anything项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号