ReasonGraph:可视化和分析大型语言模型的推理过程

ReasonGraph简介

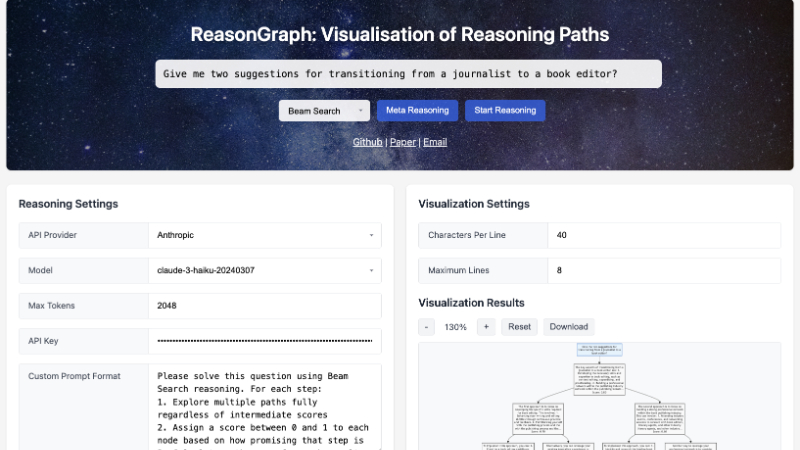

ReasonGraph是由剑桥大学和莫纳什大学的研究团队共同开发的一个基于网络的平台,旨在可视化和分析大型语言模型(LLMs)的推理过程。该平台支持顺序推理和基于树的推理方法,并与多个主流LLM提供商及超过50种先进模型集成。ReasonGraph通过直观的用户界面和实时动态图形化展示,帮助用户清晰理解复杂的推理路径,降低认知负荷,提升逻辑错误检测效率,并促进基于LLM的应用开发。其模块化设计便于扩展和集成新的推理方法与模型,同时开源特性确保了学术界、教育界和开发领域的广泛应用与可重复性。

ReasonGraph主要功能

-

推理过程可视化:

-

将LLM的推理过程以图形化方式展示,支持树形结构(如beam search)和顺序结构(如Chain-of-Thoughts、Self-refine等)的推理方法。

-

通过节点和边清晰展示推理步骤、决策点和路径选择,使复杂的推理逻辑一目了然。

-

-

多推理方法支持:

-

集成了六种主流推理方法,包括顺序推理(如链式推理、自一致性推理、逐步推理)和基于树的搜索(如树形推理、beam search)。

-

支持用户根据需求选择或切换不同的推理方法。

-

-

多模型集成:

-

与超过50种最先进的LLM模型集成,支持Anthropic、OpenAI、Google、Together.AI等主流LLM提供商。

-

通过标准化API实现模型的动态切换,适应不同模型的推理特性。

-

-

实时动态更新:

-

基于用户输入和模型输出,实时生成和更新推理路径的图形化展示。

-

支持用户在推理过程中动态调整参数,实时观察推理路径的变化。

-

-

用户友好的界面:

-

提供直观的两列布局,左侧为推理设置和原始模型输出,右侧为可视化设置和结果展示。

-

支持用户自定义可视化参数(如节点密度、布局优化),并提供导出功能。

-

-

模块化与可扩展性:

-

前端负责用户交互和图形渲染,后端通过RESTful API实现推理方法和模型的集成。

-

支持通过标准化API扩展新的推理方法和模型,无需修改框架代码。

-

ReasonGraph技术原理

-

前端可视化:

-

使用Mermaid.js实现动态图形渲染,支持树形结构和有向图布局。

-

通过异步事件处理模块响应用户操作,实时更新推理路径的图形化展示。

-

-

后端框架:

-

基于Flask构建,包含三个核心模块:配置管理器、API工厂和推理方法模块。

-

配置管理器负责状态更新和用户配置的管理;API工厂提供统一的API接口,支持多LLM提供商的集成;推理方法模块封装了不同的推理逻辑。

-

-

解析与数据处理:

-

采用基于规则的XML解析方法,从LLM输出中提取推理路径信息,解析准确率接近100%。

-

支持对不同推理方法的输出进行标准化处理,确保可视化的一致性。

-

-

模块化设计:

-

前端和后端通过RESTful API进行通信,确保组件之间的解耦和独立性。

-

每种推理方法被封装为独立模块,通过标准化API与平台集成,便于扩展和维护。

-

-

实时性能优化:

-

基于Mermaid的图形渲染时间与LLM推理时间相比可以忽略不计,确保平台在处理复杂推理任务时仍能保持高效性能。

-

通过优化后端逻辑和API调用,减少推理过程中的延迟。

-

ReasonGraph应用场景

-

学术研究:帮助研究人员深入分析不同LLM模型的推理能力,比较各种推理方法的优劣,为模型优化和新方法开发提供依据。

-

教育辅助:在教学中可视化逻辑推理过程,帮助学生理解复杂的推理逻辑,培养逻辑思维能力,直观展示不同推理方法的特点。

-

开发调试:为开发者提供推理路径的可视化,快速定位模型推理中的错误或不合理之处,优化提示工程,提升LLM应用的开发效率。

-

模型评估:通过可视化推理路径,评估模型在不同任务上的表现,分析模型的决策过程,为模型选择和改进提供参考。

-

用户教育:向非技术用户展示LLM的推理逻辑,帮助他们理解模型的决策依据,增强对模型输出的信任度。

-

产品演示:在产品开发中,通过可视化推理路径向客户展示LLM应用的逻辑和优势,提升产品的吸引力和用户体验。

ReasonGraph项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号