Geometry-Aware:修复多视角图像集中被遮挡或缺失的部分

Geometry-Aware简介

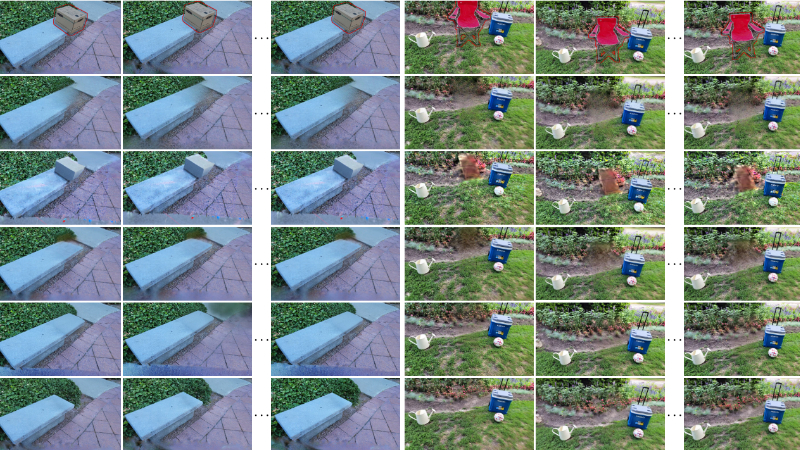

Geometry-Aware Diffusion Models是一种3D场景修复技术,用于处理多视角图像集中部分图像被遮挡或缺失的问题。该方法通过几何感知的条件生成模型,利用参考图像的几何和外观提示,实现多视角一致的图像修复。它摒弃了传统的3D辐射场,改在学习空间中融合跨视角信息,避免了因像素空间融合导致的模糊问题。此外,该方法在有限视角的场景下表现出色,能够生成高质量且跨视角一致的修复结果。实验表明,其在多个数据集上均达到了最先进的3D修复性能,尤其在少视角修复任务中优势明显。尽管该方法依赖于外部工具(如Stable Diffusion和DUSt3R),但其在处理宽基线场景和少视角输入时展现出的高效性和鲁棒性,使其成为3D场景修复领域的一项重要进展。

Geometry-Aware主要功能

-

多视角图像修复:能够修复多视角图像集中被遮挡或缺失的部分,生成几何上跨视角一致的图像。

-

少视角修复:即使在只有少量视角输入的情况下,也能生成高质量的修复结果。

-

场景完成:可以完成场景中缺失的部分,适用于宽基线场景。

-

对象移除:能够从场景中移除特定对象,并生成自然的背景替代内容。

Geometry-Aware技术原理

-

几何感知条件生成模型:

-

利用参考图像的几何和外观提示进行条件化,确保修复内容与场景的几何结构一致。

-

通过投影参考图像的外观和几何信息到目标图像平面,避免网络学习复杂的3D变换。

-

-

学习空间中的信息融合:

-

避免在像素空间中融合信息,从而减少模糊问题。

-

通过并行的每参考扩散过程和置信度掩模预测,实现跨视角信息的融合。

-

-

自回归场景修复算法:

-

迭代地修复尚未修复的图像子集,并在每次迭代后更新场景几何。

-

优先选择已修复的参考图像,逐步填充场景的几何和外观信息。

-

-

不确定性感知多参考条件:

-

预测每个参考图像的置信度掩模,以模拟对齐的几何掩模。

-

根据置信度掩模和视图距离,选择最可靠的参考信息进行融合。

-

-

多视角感知训练:

-

使用单视角图像数据集进行训练,通过单目深度估计和虚拟相机扰动生成参考图像。

-

在训练中引入几何估计错误,增强模型对不确定性的鲁棒性。

-

-

依赖外部工具:

-

使用DUSt3R进行场景几何估计,提供密集深度和相机参数。

-

使用Stable Diffusion v2作为基础模型进行修复,通过微调适应多视角修复任务。

-

Geometry-Aware应用场景

-

虚拟现实(VR)和增强现实(AR):修复虚拟场景中的缺失部分,增强沉浸感和真实感,例如在虚拟博物馆中补全损坏的文物。

-

影视特效制作:快速修复或修改场景中的物体、背景等,减少后期特效制作成本和时间,例如移除场景中的拍摄设备。

-

游戏开发:优化游戏场景的视觉效果,自动修复因视角变化导致的视觉问题,提升玩家体验。

-

三维建模与设计:在3D建模过程中,快速补全模型的缺失部分,提高建模效率,例如修复扫描不完整的建筑模型。

-

文化遗产保护:对受损的文物、古建筑等进行数字化修复,为文物保护和研究提供支持。

-

自动驾驶与机器人视觉:修复因遮挡或传感器故障导致的视觉数据缺失,提高自动驾驶系统和机器人对环境的理解和决策能力。

Geometry-Aware项目入口

- 项目主页:https://geomvi.github.io/

- arXiv研究论文:https://arxiv.org/pdf/2502.13335

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号