Qwen2.5-VL-32B:阿里开源的最新多模态模型

Qwen2.5-VL-32B简介

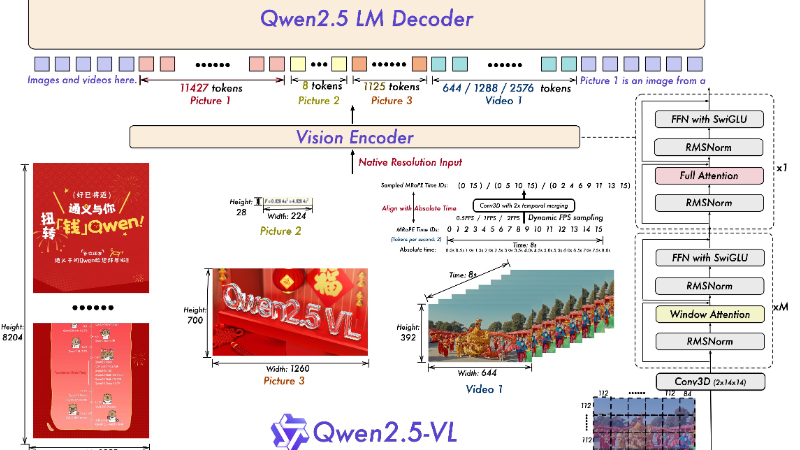

Qwen2.5-VL-32B 是由阿里巴巴团队开发的最新多模态模型,参数规模为为32B。该模型在视觉语言理解和生成方面表现出色,能够处理图像描述、视觉问答、数学推理等复杂任务。它基于Transformer架构,通过多模态预训练和强化学习优化,实现了图像与文本的深度融合和高效对齐。在多项基准测试中,Qwen2.5-VL-32B 的性能显著优于同规模模型,甚至超越了更大规模的前代版本。其开源后,为多模态研究和应用提供了强大的工具支持,展现了阿里巴巴在人工智能领域的技术实力和创新能力。

Qwen2.5-VL-32B主要功能

-

图像理解与描述:

-

能够解析图像内容,识别其中的物体、场景、人物等元素。

-

根据图像生成准确且自然的语言描述,支持细粒度的分析,例如物体的颜色、形状、位置等。

-

可以对复杂场景进行综合描述,例如街景、室内布局等。

-

-

视觉问答(VQA):

-

根据输入的图像和相关问题,生成准确的答案。

-

支持复杂视觉逻辑推导,例如判断物体之间的关系、动作等。

-

能够结合图像和文本信息进行推理,回答涉及图像内容的开放式问题。

-

-

数学推理与逻辑分析:

-

支持解决复杂的数学问题,涵盖几何、代数、概率等多领域。

-

能够进行多步骤推理,逻辑清晰,逐步展示解题过程。

-

可以结合图像中的数学信息(如图表、几何图形)进行分析和解答。

-

-

文本生成与对话:

-

根据输入的文本或图像生成自然语言回答,支持多轮对话。

-

能够根据上下文进行连贯交流,理解并回应用户的问题和指令。

-

生成的文本流畅自然,符合人类语言习惯。

-

-

跨模态生成:

-

根据文本生成对应的图像描述或创意,支持文本到图像的生成任务。

-

结合图像和文本信息生成综合内容,例如图文并茂的解释或说明。

-

Qwen2.5-VL-32B技术原理

-

多模态预训练:

-

使用大规模的图像和文本数据进行联合预训练,使模型能够学习到图像和文本之间的语义关联。

-

通过共享的编码器和解码器结构,将图像和文本信息进行融合,实现跨模态的理解和生成。

-

-

Transformer 架构:

-

基于 Transformer 架构,利用编码器处理输入的图像和文本特征,解码器生成输出结果。

-

通过自注意力机制,模型能够关注输入中的重要部分,提高对图像和文本的理解和生成准确性。

-

-

视觉语言对齐:

-

采用对比学习和对齐机制,确保图像特征和文本特征在语义空间中对齐。

-

通过多模态特征融合,使模型能够更好地理解图像和文本之间的关系,提升多模态任务的性能。

-

-

强化学习优化:

-

基于人类标注的数据和反馈进行强化学习,优化模型的输出结果。

-

通过奖励机制,使模型生成的回答更准确、逻辑更清晰、语言更流畅,更符合人类偏好。

-

-

轻量化设计:

-

在保持强大性能的同时,通过优化模型结构和参数配置,降低模型的计算复杂度和内存占用。

-

使其在实际应用中能够更高效地运行,适用于多种设备和场景。

-

Qwen2.5-VL-32B应用场景

-

教育辅助:帮助学生解决数学难题,提供清晰的解题步骤;还能辅助语言学习,提供规范、流畅的文字表达,助力写作和口语练习。

-

图像分析:能够识别图像中的细节,比如地理信息中的地形特征、颜色分布等,可用于地图标注、地理研究等;还能判断图像中物体的逻辑关系,如车辆行驶状态等。

-

智能客服:凭借自然流畅的语言风格,为用户提供智能客服服务,支持多轮对话,根据上下文理解用户需求,提供精准回答。

-

内容创作:在纯文本生成方面表现出色,可用于撰写新闻、故事等;结合图像理解能力,还能为图片生成描述性文字,辅助图文内容创作。

-

科学研究:在复杂的多步骤推理任务中表现出色,能够帮助科研人员处理复杂的逻辑和数据分析问题,提升研究效率。

-

本地化应用:由于其轻量化设计,可在本地设备上高效运行,适合对实时性要求较高的任务,比如快速图像识别、即时问答等。

Qwen2.5-VL-32B项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号