OmniTalker:阿里推出的实时文本驱动的说话头像生成框架

OmniTalker简介

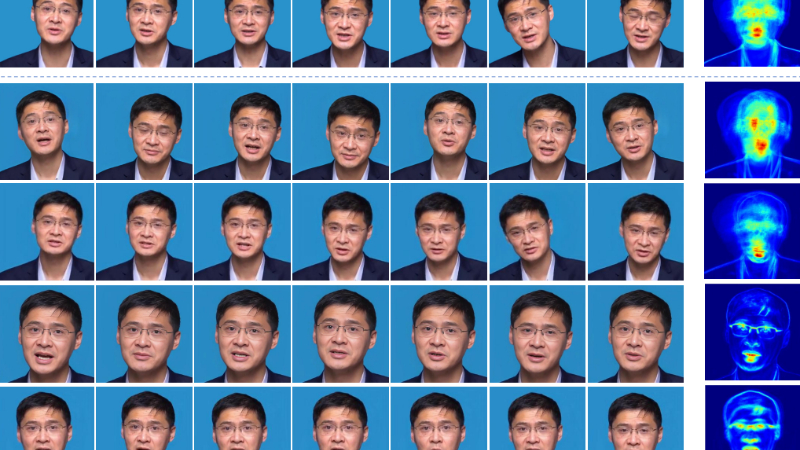

OmniTalker是由阿里巴巴集团通义实验室开发的一款实时文本驱动的说话头像生成框架。它通过创新的双分支扩散变换器架构和跨模态注意力机制,能够同时从文本和参考视频中生成同步的语音和说话头像视频,并在零样本场景下保持语音风格和面部风格的一致性。该框架解决了现有方法中存在的计算冗余、误差累积和视听风格不匹配的问题,同时实现了每秒25帧的实时推理速度,为高效、自然的人机交互提供了新的技术方案。

OmniTalker主要功能

-

实时文本驱动的语音和视频生成:OmniTalker能够根据输入的文本和参考视频,同时生成同步的语音和说话头像视频。这种功能使得机器能够以更加自然和生动的方式与用户进行交互。

-

风格保持与复制:该框架可以捕捉参考视频中的语音风格(如语调、音色)和面部风格(如表情、头部姿态),并在生成的语音和视频中保持这些风格的一致性,从而实现高保真的风格复制。

-

零样本(Zero-shot)生成:OmniTalker能够在没有针对特定人物或场景进行大量训练的情况下,直接生成高质量的语音和视频内容。这意味着它可以快速适应新的身份和场景,而无需额外的训练数据。

-

实时推理:该框架具备每秒25帧的实时推理能力,能够快速生成语音和视频内容,满足实时交互的需求,如在线视频聊天、虚拟客服等场景。

OmniTalker技术原理

-

双分支扩散变换器架构:OmniTalker采用了双分支扩散变换器(Diffusion Transformer)架构,其中一个分支专门处理音频生成,另一个分支负责视觉合成。这种架构允许模型同时处理音频和视频数据,并通过跨模态注意力机制实现两者的有效融合。

-

跨模态注意力机制:通过引入跨模态注意力机制,模型能够动态地权衡音频和视频特征的重要性,确保生成的视频与输入音频在时间上保持同步,并且在风格上保持一致。这种机制使得模型能够更好地理解和生成自然的视听内容。

-

上下文参考学习模块:该模块通过分析参考视频中的语音和面部特征,提取出风格信息,并将其嵌入到生成过程中。这种方法无需额外的风格提取模块,能够有效地捕捉和复制参考视频中的风格特征,实现零样本风格复制。

-

流匹配(Flow Matching)技术:OmniTalker利用流匹配技术进行训练,该技术通过将简单的初始分布(如高斯噪声)逐步转换为目标分布(如真实数据分布),提高了训练和推理的效率,简化了优化过程,并加快了模型的收敛速度。这使得模型能够在保持高质量输出的同时,实现快速的实时推理。

-

高效的多模态数据处理:该框架通过自动化的数据处理流程,从大规模的公开视频资源中提取高质量的多模态数据(包括音频、文本和视频)。这种数据处理方式确保了模型能够从丰富的数据中学习到多样化的风格和表达方式,从而提高生成内容的质量和适应性。

OmniTalker应用场景

-

虚拟客服:在在线客服系统中,OmniTalker可以生成与客户实时互动的虚拟客服形象,提供更加生动和自然的客户服务体验。

-

虚拟主播:用于新闻、娱乐等领域的虚拟主播,能够根据文本内容生成逼真的语音和面部表情,提高内容的吸引力和观众的参与度。

-

在线教育:在在线教育平台上,OmniTalker可以生成虚拟教师,为学生提供更加生动的教学内容,增强学习的趣味性和互动性。

-

虚拟社交:在虚拟社交应用中,用户可以使用OmniTalker生成个性化的虚拟形象,进行更加自然和真实的社交互动。

-

游戏开发:在游戏开发中,OmniTalker可以用于生成游戏中的非玩家角色(NPC),为玩家提供更加丰富的交互体验。

-

智能助手:在智能家居或智能办公环境中,OmniTalker可以为智能助手生成更加人性化的语音和面部表情,提升用户体验。

OmniTalker项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号