DeepSeek-GRM:DeepSeek联合清华推出的生成式奖励建模系统

DeepSeek-GRM简介

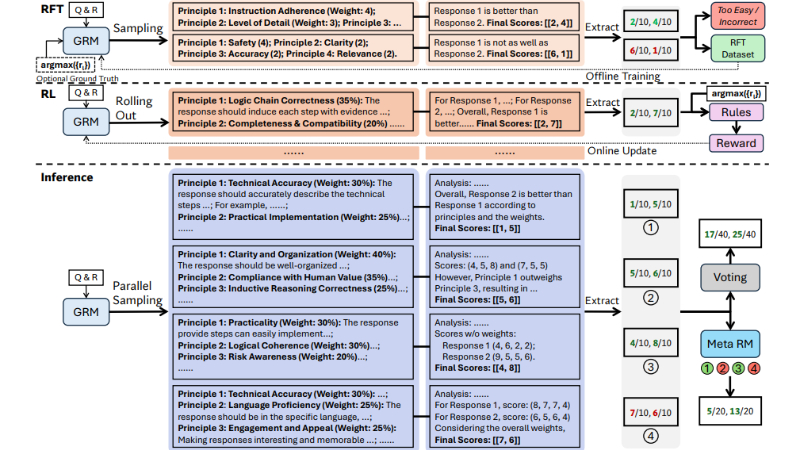

DeepSeek-GRM是由DeepSeek联合清华大学推出的生成式奖励建模(GRM)系统,旨在提升大型语言模型(LLMs)在强化学习中的推理时间可扩展性。该系统采用点式生成奖励建模方法,通过自原则批评调整(SPCT)技术,使模型能够自适应地生成原则和批评,从而在多种输入类型和领域中生成高质量的奖励信号。DeepSeek-GRM在多个奖励建模基准测试中表现出色,显著优于现有方法,尤其是在推理时间可扩展性方面,能够通过并行采样和元奖励建模进一步提升性能。该模型的开发体现了DeepSeek-AI团队在通用奖励建模领域的创新能力和对提升LLMs性能的持续探索。

DeepSeek-GRM主要功能

-

通用奖励生成:

-

DeepSeek-GRM能够为各种输入类型(包括单个、成对和多个响应)生成高质量的奖励信号,适用于广泛的领域和任务。

-

它通过生成详细的批评和评分标准,提供灵活且准确的奖励评估。

-

-

推理时间可扩展性:

-

通过并行采样和投票机制,DeepSeek-GRM能够在推理时利用更多的计算资源,显著提升奖励信号的质量和准确性。

-

引入元奖励建模(Meta RM)进一步优化投票过程,提高推理时间的可扩展性。

-

-

自适应原则生成:

-

DeepSeek-GRM能够自适应地生成与输入查询和响应相关的原则,这些原则作为评分标准,指导奖励信号的生成。

-

通过在线强化学习(RL),模型能够不断优化原则和批评的生成,以适应不同的任务和领域。

-

-

高效训练和优化:

-

采用拒绝式微调(Rejective Fine-Tuning, RFT)作为冷启动,使模型快速适应生成高质量的原则和批评。

-

结合基于规则的在线RL,进一步提升模型的奖励生成能力,确保生成的奖励信号既准确又具有多样性。

-

DeepSeek-GRM技术原理

-

点式生成奖励建模(Pointwise GRM):

-

DeepSeek-GRM采用点式生成奖励建模方法,为每个响应生成独立的评分,而不是依赖于成对比较。

-

这种方法允许模型在纯语言表示中统一处理单个、成对和多个响应的评分,提高了输入的灵活性和奖励生成的多样性。

-

-

自原则批评调整(SPCT):

-

SPCT通过在线RL训练GRM,使其能够自适应地生成原则和批评。

-

在训练过程中,模型根据输入的查询和响应生成原则,然后基于这些原则生成批评和奖励信号。

-

通过规则化的奖励信号,模型能够不断优化原则和批评的生成,提高奖励信号的质量。

-

-

并行采样和投票:

-

在推理阶段,DeepSeek-GRM通过并行采样生成多个奖励信号,然后通过投票机制聚合这些信号,生成最终的奖励。

-

这种方法不仅提高了奖励信号的多样性,还通过元奖励建模进一步优化投票过程,确保生成的奖励信号更加准确和可靠。

-

-

元奖励建模(Meta RM):

-

元奖励建模用于指导投票过程,通过评估生成的原则和批评的质量,筛选出高质量的奖励信号。

-

元RM通过二元交叉熵损失进行训练,能够识别生成的原则和批评是否正确,从而提高最终奖励信号的准确性和可靠性。

-

-

拒绝式微调(RFT):

-

RFT作为训练的冷启动阶段,通过拒绝不正确的轨迹,使模型快速适应生成高质量的原则和批评。

-

通过多次采样和拒绝机制,模型能够快速学习如何生成符合真实奖励信号的原则和批评。

-

DeepSeek-GRM应用场景

-

自然语言处理(NLP)任务:用于评估和优化语言模型生成的文本质量,如对话系统、文本生成、机器翻译等,确保生成内容的准确性和相关性。

-

强化学习中的奖励信号生成:在强化学习任务中,为智能体提供高质量的奖励信号,帮助其更好地学习和优化策略,特别是在复杂环境中的决策制定。

-

内容推荐系统:评估推荐内容的质量和相关性,为用户提供更精准的推荐,如新闻推荐、视频推荐等。

-

代码生成与评估:评估生成代码的质量和正确性,帮助开发者快速生成高质量的代码片段,提高开发效率。

-

教育领域:评估学生作业或考试答案的质量,提供详细的评分和反馈,辅助教育工作者进行更高效的教学评估。

-

医疗健康:评估医疗文本或诊断报告的质量,确保医疗信息的准确性和完整性,辅助医疗决策支持系统。

DeepSeek-GRM项目入口

- arXiv技术论文:https://arxiv.org/pdf/2504.02495

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号