AnimeGamer:腾讯联合港城大推出的无限动漫生活模拟系统

AnimeGamer简介

AnimeGamer是由腾讯PCG ARC实验室和香港城市大学联合开发的无限动漫生活模拟系统。该系统基于多模态大语言模型(MLLM),允许玩家通过开放式语言指令与动漫角色互动,生成连贯的多轮游戏状态。它通过动作感知的多模态表示捕捉动画镜头的细节,并利用视频扩散模型将这些表示解码为高质量视频片段,从而在保持上下文一致性的同时提供动态效果。开发团队还设计了自动数据收集管道,让玩家能够通过训练模型体验自己喜欢的角色。AnimeGamer在角色一致性、语义一致性和动作控制等方面表现出色,为用户带来沉浸式的游戏体验。

AnimeGamer主要功能

-

无限动漫生活模拟:

-

用户可以扮演动漫角色,通过开放式语言指令与游戏世界进行持续互动。

-

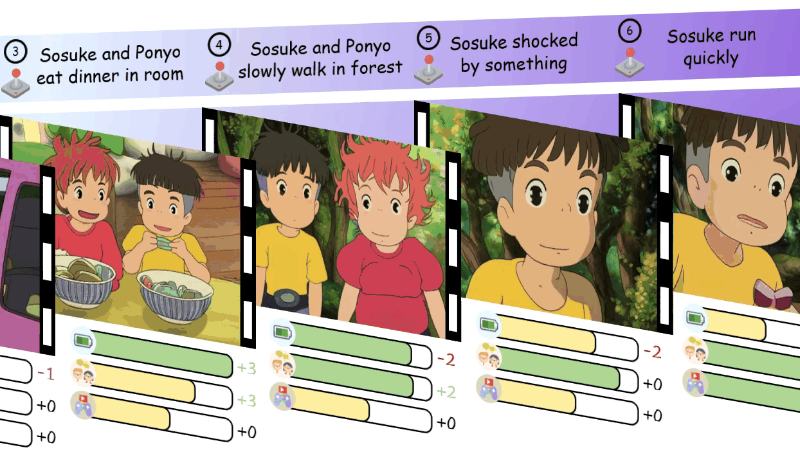

系统生成连贯的多轮游戏状态,包括动态动画镜头和角色状态更新(如体力、社交和娱乐值)。

-

-

动态动画生成:

-

利用动作感知的多模态表示,生成高质量的动态动画镜头。

-

动画镜头能够反映角色的动作和环境变化,提供沉浸式体验。

-

-

角色状态更新:

-

系统根据角色的动作和环境,动态更新角色的体力、社交和娱乐值。

-

角色状态的变化会影响后续的游戏体验,增强游戏的互动性和真实性。

-

-

自动数据收集与定制化:

-

提供自动数据收集管道,从动漫影片中提取训练数据。

-

用户可以定制自己喜欢的角色,通过训练模型生成个性化的游戏体验。

-

AnimeGamer技术原理

-

多模态大语言模型(MLLM):

-

利用MLLM作为“游戏引擎”,通过历史指令和多模态上下文预测下一个游戏状态。

-

MLLM能够理解和生成复杂的多模态内容,确保生成的游戏状态与上下文一致。

-

-

动作感知的多模态表示:

-

将动画镜头分解为三个部分:视觉参考(第一帧的CLIP嵌入)、动作描述(T5文本嵌入)和动作范围(光流计算的动作强度)。

-

这些表示能够捕捉动画镜头的细节,并作为解码器的输入,生成高质量的视频片段。

-

-

视频扩散模型:

-

使用视频扩散模型(如CogvideoX)将多模态表示解码为动态动画镜头。

-

通过微调解码器,进一步提高生成视频的质量和一致性。

-

-

上下文一致性:

-

通过历史多模态上下文作为输入,预测后续的游戏状态,确保生成内容的连贯性和一致性。

-

使用滑动窗口技术处理长序列生成任务,支持理论上无限的游戏生成。

-

-

自动数据收集与标注:

-

从动漫影片中提取视频片段,并利用预训练的视觉语言模型(如InternVL)进行标注。

-

自动生成角色动作、环境描述和角色状态信息,用于模型训练和评估。

-

AnimeGamer应用场景

-

互动式动漫游戏开发:为玩家提供沉浸式的动漫角色扮演体验,玩家可以通过语言指令控制角色行为,探索动态生成的游戏世界。

-

动漫内容创作辅助:帮助动漫创作者快速生成角色动画和场景,为故事创作提供灵感和素材,提高创作效率。

-

个性化娱乐体验:用户可以根据自己的喜好选择动漫角色和场景,生成个性化的动漫故事,享受独特的娱乐体验。

-

教育与培训:在教育领域,通过动漫角色模拟历史事件或科学实验,增加学习的趣味性和互动性,提高学习效果。

-

虚拟社交互动:用户可以与动漫角色进行虚拟社交,通过语言交流和互动,增强社交体验,满足不同用户的社交需求。

-

广告与营销:品牌可以利用AnimeGamer生成与品牌相关的动漫内容,吸引年轻消费者,提升品牌知名度和用户参与度。

AnimeGamer项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号