ACTalker:腾讯联合清华大学等推出的端到端视频扩散框架

ACTalker简介

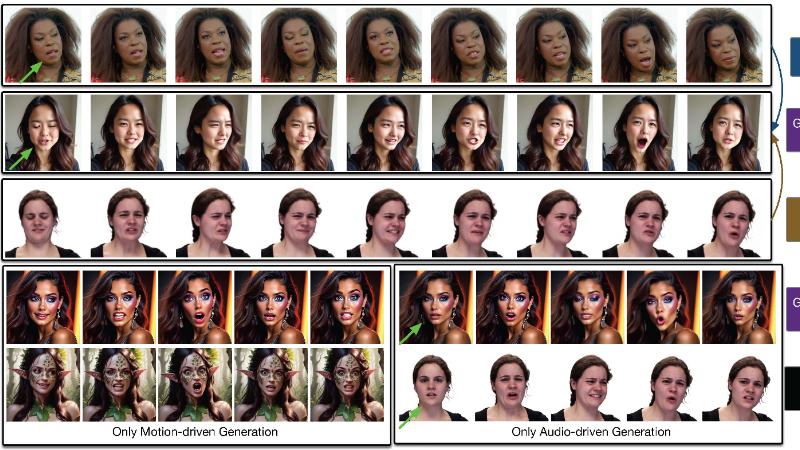

ACTalker是由香港科技大学、腾讯和清华大学联合开发的端到端视频扩散框架,专门用于自然的“说话头”视频生成。该框架能够同时支持多信号控制和单信号控制,通过创新的并行控制曼巴(Parallel-Control Mamba,PCM)层和掩码选择性状态空间模型(Mask-SSM)单元,解决了多信号控制中的冲突问题。开发团队通过引入掩码丢弃(mask-drop)策略,允许每个驱动信号独立控制其对应的面部区域,从而提高了视频生成的自然度和表达力。ACTalker在多信号视频合成方面取得了优于现有方法的结果,为虚拟形象和人机交互领域带来了新的技术突破。

ACTalker主要功能

-

多信号控制:

-

支持同时使用音频和面部表情信号来控制视频生成,解决了多信号之间的冲突问题。

-

提供灵活的控制方式,可以单独使用音频或面部表情信号,也可以同时使用两种信号。

-

-

自然的说话头视频生成:

-

生成的视频具有高自然度和表达力,能够准确同步音频和面部表情。

-

支持高分辨率视频生成,适用于虚拟形象和人机交互场景。

-

-

精确的面部控制:

-

通过掩码选择性状态空间模型(Mask-SSM),实现对特定面部区域的精确控制,如嘴唇、眼睛等。

-

保持身份一致性,即使在复杂的面部表情变化中也能保持人物的身份特征。

-

ACTalker技术原理

-

并行控制曼巴层(Parallel-Control Mamba,PCM):

-

多分支结构:PCM层包含多个并行的Mask-SSM单元,每个单元处理一个驱动信号及其对应的掩码,实现多信号的并行控制。

-

门控机制:每个分支中引入门控机制,训练时随机设置门控状态,推理时可以手动修改门控状态,实现灵活的单信号或双信号控制。

-

-

掩码选择性状态空间模型(Mask-SSM):

-

掩码丢弃策略(Mask-Drop):通过掩码丢弃无关的特征标记,减少计算复杂度,同时增强驱动信号对目标区域的控制能力,解决控制冲突。

-

状态空间模型(SSM):利用SSM结构高效地聚合特征标记与驱动信号,实现时空维度上的特征融合,提高生成视频的自然度。

-

-

身份嵌入(Identity Embedding):

-

在PCM层中注入身份嵌入,确保在操纵特定面部区域时保持人物的身份特征。

-

通过身份嵌入与驱动信号的结合,实现身份与表情的解耦,提高生成视频的稳定性和一致性。

-

-

视频扩散模型(Video Diffusion Model):

-

基于稳定的视频扩散模型(Stable Video Diffusion),结合音频和面部表情信号,生成高质量的视频。

-

通过优化的训练目标和分类器自由引导(Classifier-Free Guidance,CFG),进一步提升生成视频的质量和自然度。

-

ACTalker应用场景

-

虚拟形象与数字人:为虚拟主播、虚拟客服等数字人生成自然的说话头视频,提升交互体验。

-

视频会议与远程协作:在视频会议中,根据音频信号生成自然的面部表情和口型,改善远程沟通效果。

-

游戏与互动娱乐:在游戏和互动娱乐中,根据玩家的语音或表情生成实时的虚拟角色动画,增强沉浸感。

-

教育与培训:用于在线教育平台,生成生动的虚拟教师形象,提高学习的趣味性和吸引力。

-

社交媒体与内容创作:帮助创作者快速生成个性化的视频内容,如虚拟Vlog、动画短片等,丰富内容生态。

-

智能客服与虚拟助手:在智能客服系统中,生成自然的虚拟助手形象,提升用户与机器交互的自然度和友好度。

ACTalker项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号