InstantCharacter:腾讯联合InstantX推出的角色定制化框架

InstantCharacter项目简介

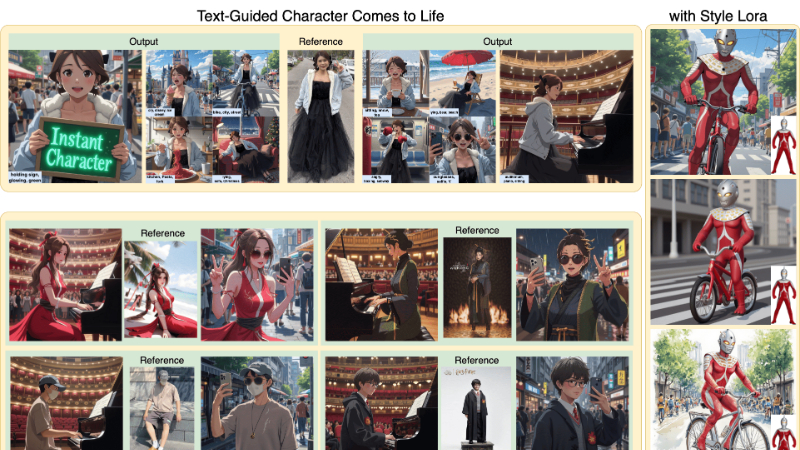

InstantCharacter是由腾讯混元团队和InstantX团队共同开发的创新性角色定制化框架。它基于可扩展的扩散变换器(Diffusion Transformer),旨在解决现有角色驱动图像生成方法在泛化能力和图像质量上的局限性。InstantCharacter通过其独特的可扩展适配器设计和三阶段训练策略,实现了跨多种角色外观、姿势和风格的高保真个性化图像生成。该框架利用大规模数据集进行训练,能够同时优化角色一致性和文本可编辑性。InstantCharacter在生成高保真、文本可控且角色一致的图像方面表现出色,为角色驱动的图像生成树立了新的标杆,广泛应用于游戏角色设计、漫画创作、故事插图、影视制作、电商广告和社交媒体内容创作等领域。

InstantCharacter主要功能

-

开放域个性化:

-

能够生成具有不同外观、姿势和风格的角色图像,覆盖从照片级真实感肖像到动漫游戏角色等多种类型。

-

保持高保真度,确保生成图像的质量和细节。

-

-

文本可控性:

-

支持通过文本提示对角色进行精确控制,例如改变角色的动作、场景和风格。

-

生成的图像能够准确反映文本描述的内容。

-

-

角色一致性:

-

在生成不同场景和动作的角色图像时,保持角色的身份特征和细节一致。

-

避免角色特征在生成过程中丢失或变形。

-

-

风格切换:

-

支持灵活切换不同的艺术风格,如宫崎骏风格和新海诚风格,同时保持角色一致性和文本可编辑性。

-

InstantCharacter技术原理

-

可扩展适配器设计:

-

通用视觉编码器:使用SigLIP和DINOv2作为图像编码器,提取角色的通用特征,通过通道级连接整合特征,捕捉更细致的纹理信息。

-

中间编码器:采用双流特征融合策略,分别提取低级和区域级特征,并通过专用的中间变换器编码器进行层次化整合,确保多级特征的互补性。

-

投影头:将细化的角色特征通过投影头投影到去噪空间,并与潜在噪声交互,通过时间步感知的Q-former处理中间编码器输出,并通过可学习的交叉注意力层注入去噪空间。

-

-

三阶段训练策略:

-

第一阶段:使用未配对数据进行低分辨率预训练,以保持角色的结构一致性。

-

第二阶段:使用低分辨率配对数据进行训练,增强文本控制能力,确保生成图像准确反映文本描述。

-

第三阶段:使用高分辨率联合训练,提高图像质量和纹理细节,生成高保真且文本可控的角色图像。

-

-

大规模数据集:

-

构建了一个包含1000万级样本的大规模角色数据集,数据集分为配对(多视图角色)和未配对(文本-图像组合)子集。

-

通过不同的学习路径同时优化角色一致性和文本可编辑性,提高模型的泛化能力和生成质量。

-

-

基于扩散变换器的框架:

-

利用现代扩散变换器(如FLUX)的强大生成能力和灵活性,作为基础模型。

-

通过可扩展适配器与基础模型的潜在空间无缝交互,确保角色特征与生成空间的有效对齐。

-

InstantCharacter应用场景

-

游戏角色设计:快速生成具有不同外观和风格的游戏角色,支持开发者根据游戏设定灵活调整角色动作和场景。

-

漫画创作:为漫画家提供个性化角色生成工具,根据文本描述快速生成不同姿势和风格的角色,提高创作效率。

-

故事插图:根据故事文本生成与情节匹配的角色图像,帮助插画师快速完成插图创作,保持角色一致性。

-

影视制作:在影视特效和动画制作中,快速生成符合剧本描述的角色形象,支持不同场景和动作的生成,降低制作成本。

-

电商广告:为电商广告生成个性化的产品展示图像,将角色与产品自然融合,提升广告吸引力。

-

社交媒体内容创作:帮助内容创作者根据主题生成个性化角色图像,用于制作有趣的社交媒体帖子和短视频,吸引用户关注。

InstantCharacter项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号