TesserAct:哈佛大学等推出的4D体现世界模型

TesserAct项目简介

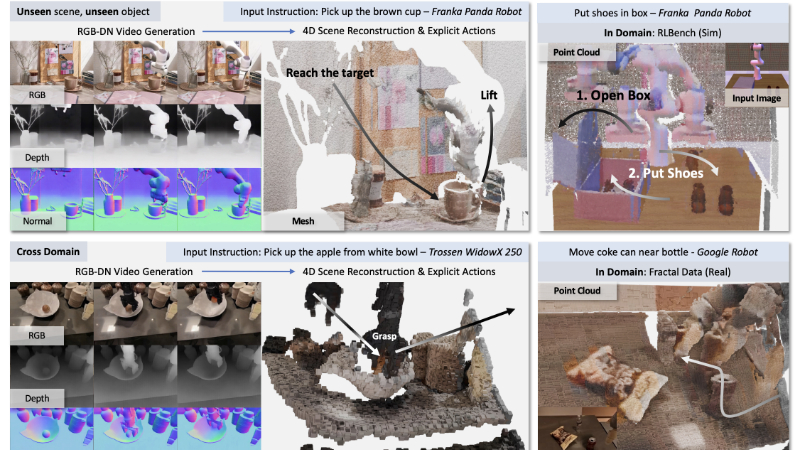

TesserAct 是由 UMass Amherst、HKUST 和 Harvard University 的研究团队共同开发的一种创新的 4D 体现世界模型。该模型通过输入图像和文本指令,能够生成 RGB、深度和法线视频,并重建出具有时空一致性的 4D 场景,同时预测相应的动作。TesserAct 在学习三维场景随时间的动态变化方面表现出色,不仅在域内数据上取得了优异的性能,还能有效泛化到未见场景、新对象以及跨域场景。开发团队通过构建高质量的 4D 数据集,并引入新颖的损失函数来优化场景重建,使得 TesserAct 在机器人动作规划等下游任务中展现了强大的应用潜力,为智能体现代理的发展提供了新的基础。

TesserAct主要功能

-

4D 场景生成与重建:

-

输入图像和文本指令后,TesserAct 能够生成 RGB、深度和法线视频,并将其整合为高质量的 4D 场景。

-

生成的 4D 场景在时间和空间上具有一致性,能够准确反映物体的动态变化和几何信息。

-

-

动作预测与规划:

-

基于生成的 4D 场景,TesserAct 可以预测机器人的动作,例如抓取物体、移动物体等。

-

通过逆动力学模型,结合当前状态和预测的未来状态,生成精确的 7 自由度动作指令。

-

-

泛化能力:

-

TesserAct 能够在未见场景、新对象和跨域场景中有效工作,展现出强大的泛化能力。

-

该模型不仅适用于模拟数据,还能在真实世界数据中表现出色。

-

-

多模态输入支持:

-

支持 RGB、深度和法线等多种模态的输入,能够生成更丰富的场景信息。

-

通过文本指令和图像输入,实现对机器人动作的精确控制。

-

TesserAct技术原理

-

数据集构建:

-

结合合成数据和真实世界数据,构建了包含 RGB、深度和法线信息的 4D 体现视频数据集。

-

使用深度估计器(如 RollingDepth)和法线估计器(如 Marigold)为真实世界数据补充深度和法线信息。

-

-

模型架构:

-

基于 CogVideoX 架构,利用变分自编码器(VAE)分别对 RGB、深度和法线视频进行编码。

-

通过扩散模型(Diffusion Model)进行训练,预测未来的 RGB、深度和法线视频。

-

-

4D 场景重建:

-

利用深度和法线信息优化深度图,通过光流(Optical Flow)技术区分静态和动态区域。

-

引入一致性损失(Consistency Loss)和正则化损失(Regularization Loss),确保场景在时间和空间上的连贯性。

-

-

动作规划:

-

使用逆动力学模型(Inverse Dynamics Model),结合 4D 点云和文本指令,预测机器人的动作。

-

通过 PointNet 提取点云特征,并结合语言嵌入,生成精确的动作指令。

-

-

优化与训练:

-

采用多分辨率训练方法,优化模型的生成能力和泛化能力。

-

使用梯度检查点(Gradient Checkpointing)技术优化内存使用,并通过指数移动平均(EMA)稳定训练过程。

-

TesserAct应用场景

-

机器人抓取任务:通过生成 4D 场景和预测动作,TesserAct 能够帮助机器人更精准地抓取物体,即使在复杂环境中也能有效识别物体的位置和姿态。

-

自动化装配:在工业生产中,TesserAct 可以用于自动化装配任务,通过预测物体的动态变化和机器人的动作,提高装配效率和精度。

-

智能家居控制:在智能家居环境中,TesserAct 可以通过理解场景动态和用户指令,实现对家居设备的智能化控制,例如自动开门、开窗等。

-

虚拟现实与增强现实:TesserAct 生成的 4D 场景可以用于虚拟现实和增强现实应用,为用户提供更加逼真的交互体验,例如虚拟场景中的物体操作。

-

自动驾驶:在自动驾驶领域,TesserAct 可以帮助车辆更好地理解周围环境的动态变化,预测其他车辆和行人的行为,从而提高驾驶安全性。

-

医疗机器人:在医疗场景中,TesserAct 可以辅助手术机器人进行更精准的操作,通过实时生成的 4D 场景和动作预测,提高手术的准确性和安全性。

TesserAct项目入口

- 项目官网:https://tesseractworld.github.io/

- Github仓库:https://github.com/UMass-Embodied-AGI/TesserAct

- HuggingFace模型库:https://huggingface.co/anyeZHY/tesseract

- arXiv技术论文:https://arxiv.org/pdf/2504.20995

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号