ICEdit:浙大联合哈佛大学推出的新型指令式图像编辑方法

ICEdit项目简介

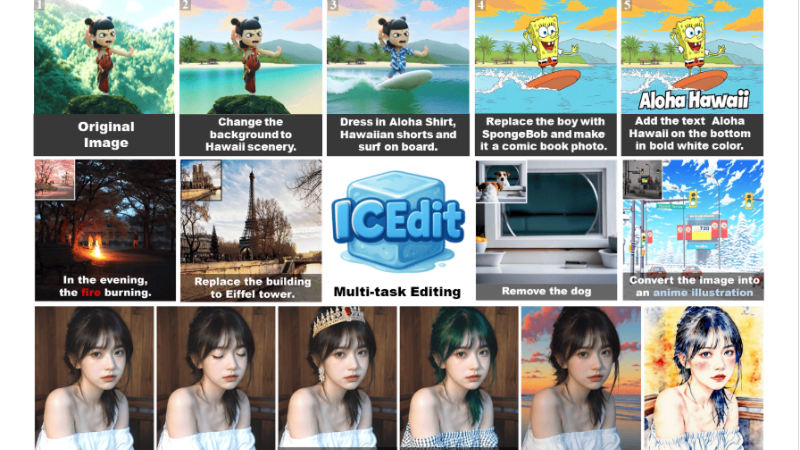

ICEdit是由浙江大学与哈佛大学共同开发的一种新型指令式图像编辑方法。该方法基于大规模扩散变换器(Diffusion Transformer),通过上下文生成技术实现了高效且精准的图像编辑。ICEdit的核心优势在于其数据和参数效率:它仅需0.5%的训练数据和1%的参数量,即可达到甚至超越现有最先进方法的编辑效果。开发团队通过创新的LoRA-MoE混合微调策略和早期过滤推理时间缩放技术,显著提升了编辑质量和成功率,同时保持了模型的高效性。ICEdit不仅在基准测试中表现出色,还在多种实际应用中展现了强大的泛化能力和自然的编辑效果,为指令式图像编辑领域带来了新的突破。

ICEdit主要功能

-

高精度图像编辑:

-

根据自然语言指令对图像进行精确修改,支持多种编辑任务,如背景替换、风格转换、物体添加或删除等。

-

能够保持图像主体的一致性和自然性,同时对未编辑区域进行高保真度的保留。

-

-

多轮编辑与多任务支持:

-

支持连续多轮编辑,用户可以根据前一次的编辑结果继续调整,实现复杂的图像创作。

-

兼容多种编辑任务,如风格化、动漫化、文字添加等,满足多样化的需求。

-

-

高效的数据和参数利用:

-

仅需0.5%的训练数据和1%的可训练参数,相比传统方法大幅减少了资源消耗,提升了编辑效率。

-

-

自然融合与和谐编辑:

-

编辑结果能够自然地融入原始图像,避免了常见的编辑痕迹或突兀感,例如自动添加阴影效果和风格对齐。

-

ICEdit技术原理

-

基于上下文的编辑框架(In-Context Editing Framework):

-

利用扩散变换器(Diffusion Transformer)的上下文感知能力,通过“上下文提示”(In-Context Prompt)实现零样本(zero-shot)指令遵从。

-

将编辑指令嵌入到生成提示中,使模型能够理解并执行编辑任务,无需对模型结构进行修改。

-

-

LoRA-MoE混合微调策略:

-

结合低秩适配器(LoRA)和混合专家(MoE)路由,动态激活任务特定的专家网络,提高模型对多样化编辑任务的适应性。

-

LoRA通过参数高效的微调增强模型的编辑能力,而MoE通过动态专家选择实现对不同编辑任务的专门处理,避免了单一模型结构的局限性。

-

-

早期过滤推理时间缩放方法:

-

在推理阶段,通过视觉语言模型(VLM)评估初始噪声分布,选择与编辑指令更一致的噪声候选。

-

通过少量的去噪步骤快速筛选出最佳的初始噪声,然后进行更长时间的去噪处理,从而提高编辑质量和一致性。

-

-

扩散模型的高效生成能力:

-

利用扩散模型的生成能力和上下文感知机制,能够直接处理源图像和目标图像之间的交互,无需额外的对齐网络。

-

通过优化扩散过程中的噪声采样和去噪步骤,实现高质量的图像编辑效果。

-

ICEdit应用场景

-

创意设计:根据用户输入的创意指令,快速生成符合设计需求的图像,如添加特定元素、改变风格或色彩,助力设计师高效创作。

-

广告制作:快速修改广告图像中的背景、产品外观或添加品牌元素,提升广告的吸引力和针对性,满足不同营销场景的需求。

-

影视后期:用于影视特效制作,如替换场景背景、添加特效元素或调整角色外观,降低后期制作成本,提高制作效率。

-

游戏开发:根据游戏风格和需求,快速生成或修改游戏场景、角色和道具的图像,加速游戏开发流程,丰富游戏视觉效果。

-

社交媒体内容创作:用户可以根据自己的想法快速修改照片或生成创意图像,如添加文字、特效或风格化处理,提升内容的趣味性和吸引力。

-

教育与培训:在教育领域,用于生成教学所需的图像示例,如修改历史场景、科学实验图像或艺术作品,帮助学生更好地理解和学习。

ICEdit项目入口

- 项目官网:https://river-zhang.github.io/ICEdit-gh-pages

- GitHub仓库:https://github.com/River-Zhang/ICEdit

- HuggingFace模型库:https://huggingface.co/sanaka87/ICEdit-MoE-LoRA

- arXiv技术论文:https://arxiv.org/pdf/2504.20690

- 在线体验Demo:https://huggingface.co/spaces/RiverZ/ICEdit

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号