Insert Anything:浙大联合哈佛大学等推出的图像插入框架

Insert Anything项目简介

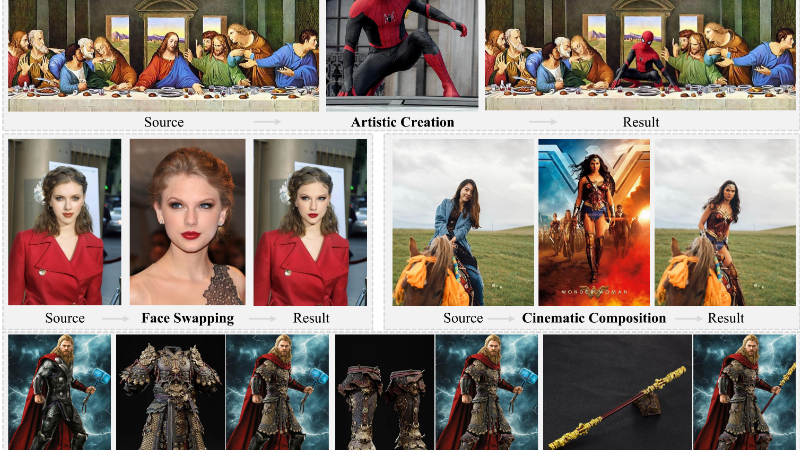

“Insert Anything”是由浙江大学、哈佛大学和南洋理工大学联合开发的创新图像插入框架。该框架能够将参考图像中的对象无缝集成到目标场景中,支持掩码和文本引导的编辑模式,具备强大的泛化能力。开发团队通过AnyInsertion数据集进行训练,涵盖人物、物体和服装等多种插入任务,为模型提供了丰富的训练资源。利用Diffusion Transformer(DiT)的多模态注意力机制,结合上下文编辑机制,Insert Anything能够实现参考元素与目标场景的自然融合,同时保留其独特特征。该框架在多个基准测试中表现优异,展现出在创意内容生成、虚拟试穿、场景合成等领域的巨大应用潜力,为图像编辑领域带来了新的突破。

Insert Anything主要功能

-

多任务图像插入:

-

人物插入:将人物从参考图像无缝集成到目标场景中,支持复杂的人物交互和背景融合。

-

物体插入:支持将各种物体(如家具、配饰等)插入到目标图像中,保持物体的细节和风格一致性。

-

服装插入:实现虚拟试穿功能,将服装从参考图像插入到目标人物图像中,支持服装的自然贴合和风格匹配。

-

-

灵活的控制模式:

-

掩码引导编辑:通过手动提供的掩码指定插入区域,精确控制插入对象的位置和范围。

-

文本引导编辑:通过文本描述指定插入对象的修改方式,支持更灵活的创意表达。

-

-

上下文感知编辑:

-

双联画结构(掩码引导):将参考图像与部分掩码的目标图像拼接,形成双联画结构,确保插入元素与目标场景的自然融合。

-

三联画结构(文本引导):将参考图像、未修改的目标图像和待填充的空区域拼接,形成三联画结构,提供更丰富的上下文信息。

-

-

高质量生成效果:

-

细节保留:通过上下文编辑机制和多模态注意力机制,保留参考对象的高频率细节(如纹理、颜色等)。

-

视觉和谐:确保插入元素与目标场景在风格、色彩和纹理上的一致性,避免视觉冲突。

-

Insert Anything技术原理

-

大规模数据集支持:

-

AnyInsertion数据集:包含120K提示-图像对,涵盖人物、物体和服装等多种插入任务,支持掩码和文本提示,为模型训练提供丰富的数据资源。

-

-

多模态注意力机制:

-

DiT架构:利用Diffusion Transformer(DiT)的多模态注意力机制,联合建模文本、掩码和图像块之间的关系,支持掩码和文本引导的编辑任务。

-

语义引导:通过CLIP图像编码器提取参考图像的语义特征,为编辑过程提供上下文信息。

-

-

上下文编辑机制:

-

双联画结构:将参考图像与部分掩码的目标图像拼接,形成双联画结构,附加二进制掩码以指定参考和插入区域。

-

三联画结构:将参考图像、未修改的目标图像和待填充的空区域拼接,形成三联画结构,附加二进制掩码以标记不同区域。

-

-

掩码和文本引导的编辑:

-

掩码引导编辑:通过掩码指定插入区域,结合参考图像的语义特征,生成与目标场景自然融合的结果。

-

文本引导编辑:通过文本描述指定插入对象的修改方式,结合参考图像的语义特征,生成符合文本描述的结果。

-

-

自适应裁剪策略:

-

动态裁剪:在推理时,根据插入元素的面积比例动态调整裁剪区域,确保高频率细节的保留,同时保持足够的上下文信息。

-

-

混合掩码策略:

-

掩码类型:结合实例掩码和框掩码,针对不同插入类别(如人物、物体、服装)进行优化,提高模型对自由形状掩码和姿态引导的适应性。

-

Insert Anything应用场景

-

虚拟试穿:在电商平台上,用户可以实时预览不同服装或配饰在自己身上的效果,提升购物体验。

-

创意设计:艺术家和设计师可以快速将创意元素插入到设计草图或背景中,加速创作流程。

-

影视制作:在电影或广告中,快速合成特效场景,将虚拟角色或道具无缝融入真实画面。

-

社交媒体内容创作:用户可以轻松生成个性化的图像内容,如虚拟背景替换或添加趣味元素。

-

游戏开发:快速生成游戏场景中的角色或道具,提升开发效率。

-

家居设计:用户可以预览不同家具或装饰品在房间中的效果,辅助家居布置决策。

Insert Anything项目入口

项目地址:https://song-wensong.github.io/insert-anything/

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号