UniAnimate项目简介

UniAnimate是由华中科技大学、阿里巴巴集团和中国科学技术大学联合研发的高效视频动画技术。它通过统一的视频扩散模型,简化了人物图像到动态视频的转换过程,无需额外对齐模型,便能生成长时间且连贯的高质量动画。这项技术不仅优化了视频生成的效率,还大幅提升了动画的自然流畅度,为视频制作和虚拟现实等领域带来了创新的应用潜力。

UniAnimate主要功能

❶高质量视频生成:能够根据给定的参考图像和目标姿势序列生成高分辨率和逼真度的视频内容。

❷时间连贯性:确保视频在时间维度上的动作流畅和连贯,避免出现不自然的动作跳跃或断裂。

❸长视频支持:与仅能生成短片段的视频生成技术相比,UniAnimate能够生成更长时长的视频,满足更广泛的应用需求。

❹优化负担降低:通过统一的视频扩散模型减少了额外的参考模型需求,降低了模型训练和优化的复杂度。

❺参数数量减少:统一结构减少了模型参数数量,使得模型更加轻量化,优化过程更为高效。

❻迭代首帧条件策略:使用首帧条件策略来生成后续视频帧,确保视频段与段之间的过渡平滑,增强整体视频的一致性。

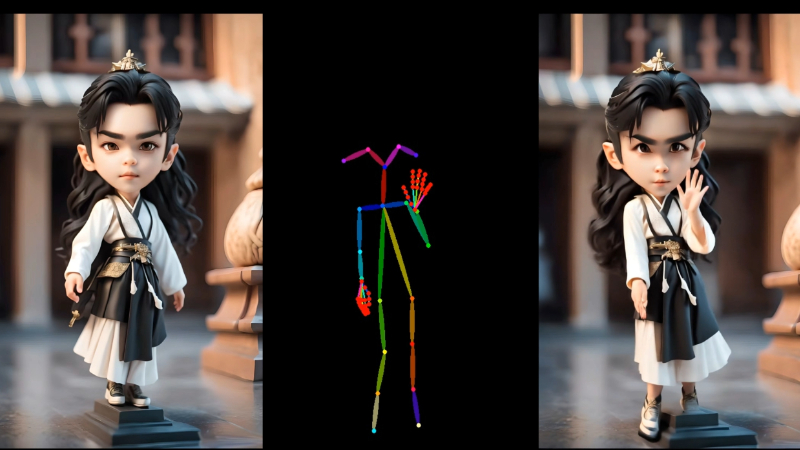

❼跨域转移能力:展示出色的跨域转移能力,即使在未见过的领域(如卡通角色舞蹈视频)也能生成高质量的视频。

UniAnimate应用场景

❶电影和视频制作:用于生成电影中的特效场景或动画,减少实际拍摄成本和时间。

❷虚拟现实(VR):在虚拟现实环境中创建逼真的动态角色,提升沉浸式体验。

❸游戏开发:为电子游戏中的非玩家角色(NPC)生成自然流畅的动作和表情。

❹广告行业:制作吸引人的广告内容,通过动态视频展示产品或服务。

❺社交媒体:用户可以创建个性化的动态视频内容,用于社交媒体平台分享。

❻教育和培训:生成教学视频中的动态演示或角色扮演,使学习材料更加生动有趣。

UniAnimate技术原理

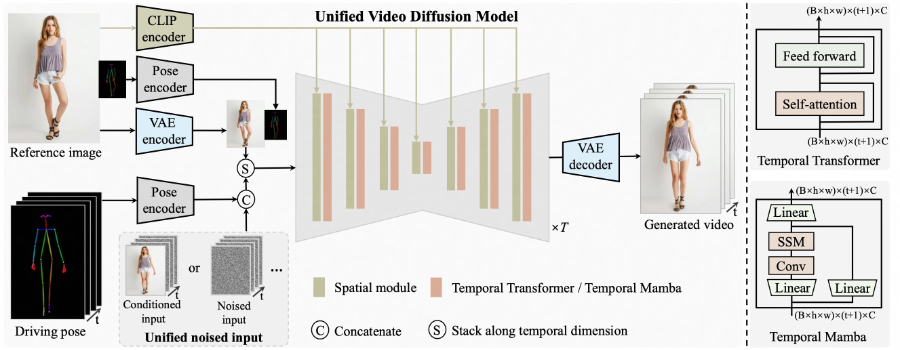

❶统一视频扩散模型:将参考图像和噪声视频映射到一个共同的特征空间,简化了特征对齐和视频生成的过程。

❷统一噪声输入:支持随机噪声输入和首帧条件输入,增强了生成长期视频的能力。

❸时间建模架构:采用状态空间模型(如Temporal Mamba)替代传统的时间Transformer,以提高处理长视频序列的效率。

❹首帧条件策略:利用前一视频段的最后一帧作为下一视频段的起始帧,确保视频段之间的平滑过渡和连贯性。

UniAnimate项目入口

- 官方项目主页:https://unianimate.github.io/

- GitHub源码库:https://github.com/ali-vilab/UniAnimate

- arXiv研究论文:https://arxiv.org/abs/2406.01188

粤公网安备44011102483711号

粤公网安备44011102483711号