Qwen2模型简介

Qwen2是由阿里云Qwen团队推出的一系列先进的预训练语言模型,它们在Qwen1.5的基础上进行了重大升级。这些模型包括从小型到超大型不等的五个版本,支持多达29种语言,特别增强了对中文和英语的理解能力。Qwen2在多个评测基准上展现出卓越的性能,尤其在代码编写、数学问题解决以及长文本处理方面有显著提升。此外,Qwen2-72B模型支持高达128K tokens的上下文长度,使其在处理复杂任务时更加得心应手。该系列模型已在Hugging Face和ModelScope开源,供全球研究者和开发者使用,推动了人工智能技术的进一步发展和应用。

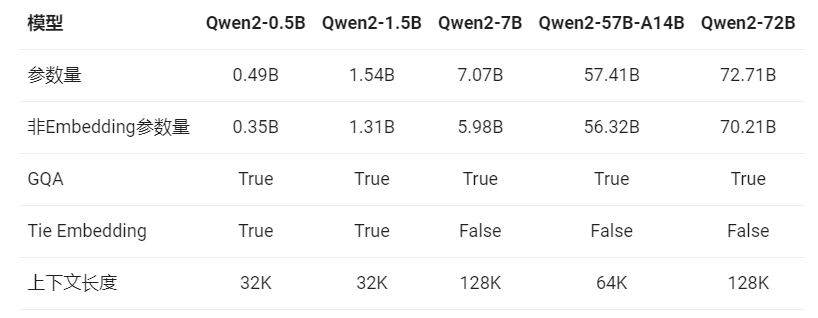

Qwen2模型信息

Qwen2系列包含5个尺寸的预训练和指令微调模型,其中包括Qwen2-0.5B、Qwen2-1.5B、Qwen2-7B、Qwen2-57B-A14B和Qwen2-72B。如下表所示:

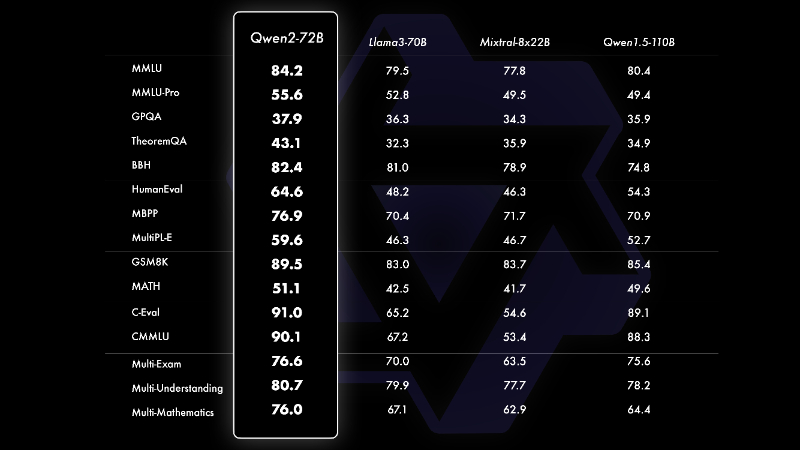

Qwen2模型评测

相比Qwen1.5,Qwen2在大规模模型实现了非常大幅度的效果提升。在针对预训练语言模型的评估中,对比当前最优的开源模型,Qwen2-72B在包括自然语言理解、知识、代码、数学及多语言等多项能力上均显著超越当前领先的模型,如Llama-3-70B以及Qwen1.5最大的模型Qwen1.5-110B。这得益于其预训练数据及训练方法的优化。

Qwen2模型亮点

❶多尺寸模型:提供从0.5B到72B参数量的5种不同尺寸模型,以适应不同应用场景的需求。

❷多语言支持:在中文和英文基础上,增加了27种语言的高质量数据,强化了模型的多语言能力。

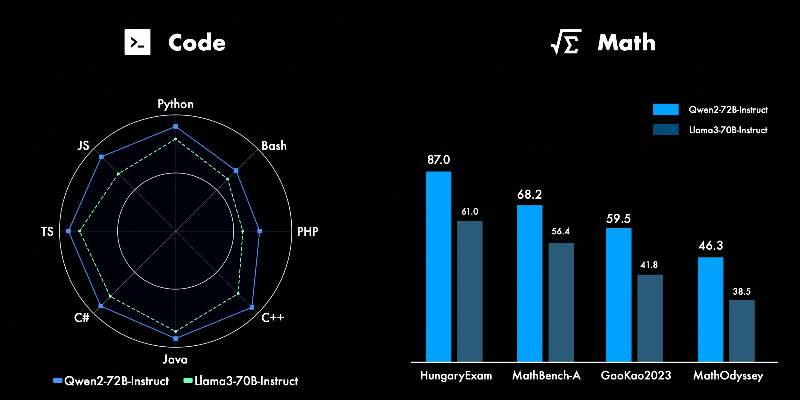

❸性能领先:在多个评测基准上,Qwen2特别是Qwen2-72B模型在自然语言理解、知识、代码、数学和多语言等多项能力上超越了当前领先的模型。

❹代码与数学能力:通过融合CodeQwen1.5的经验,Qwen2在多种编程语言上表现显著,同时大规模高质量数据助力其数学解题能力大幅提升。

❺长文本处理:Qwen2-72B-Instruct等模型通过技术如YARN支持长达128K tokens的上下文长度,优化了长序列理解能力。

❻安全性:在多语言不安全查询类别中,Qwen2-72B-Instruct显示出与GPT-4相当的安全性水平,显著优于其他模型。

Qwen2官网入口

- 官方博客介绍:https://qwenlm.github.io/zh/blog/qwen2/

- GitHub地址:https://github.com/QwenLM/Qwen2

- Hugging Face地址:https://huggingface.co/Qwen

- 魔塔社区地址:https://modelscope.cn/organization/qwen

- Hugging Face Demo:https://huggingface.co/spaces/Qwen/Qwen2-72B-Instruct

粤公网安备44011102483711号

粤公网安备44011102483711号