Stable-Audio-Open简介

Stable-Audio-Open是StabilityAI推出的开源音乐生成模型,它基于先进的文本到音频生成技术,能够根据用户输入的文本描述生成高质量的音效和乐段。这款模型利用了广泛的音频数据集进行训练,确保了生成的音频具有丰富的多样性和广泛的应用价值。Stable-Audio-Open不仅为音乐创作者和音效设计师提供了全新的创作工具,也为研究者们提供了深入探索音频生成领域的平台。无论是用于个性化音效制作还是学术研究,Stable-Audio-Open都展现出了其强大的潜力和价值。

Stable-Audio-Open主要功能

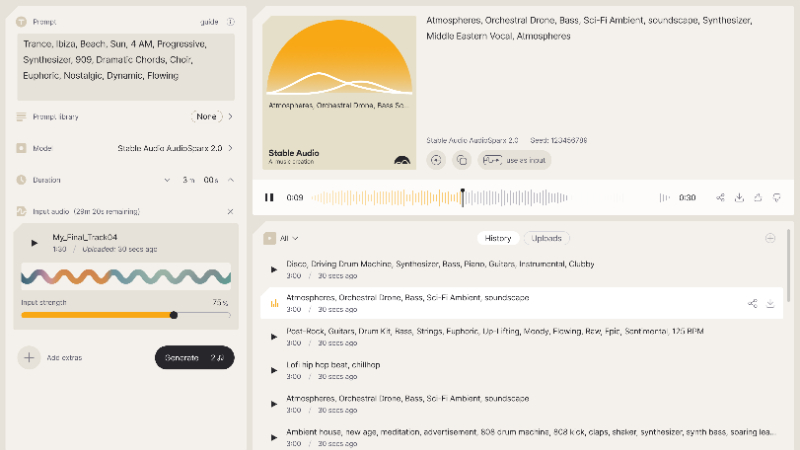

❶文本到音频生成:用户可以通过输入描述音乐元素(如乐器、节奏、旋律等)的文本,让它生成对应的音频内容。

❷高质量的音效和乐段生成:模型基于深度学习技术,能够生成高质量、逼真的音效和乐段,满足用户的不同需求。

❸支持多种乐器声音:它能够生成包括钢琴、吉他、鼓点等在内的多种乐器声音,为用户提供了丰富的选择。

❹支持音效设计:除了乐器声音外,模型还能够生成环境声音、特殊音效等,适用于音效设计和游戏开发等领域。

❺可定制性:用户可以根据自身需求,通过微调模型参数或使用特定的文本描述,定制生成具有特定风格的音频片段。

Stable-Audio-Open应用场景

❶音乐创作:快速生成乐器演奏片段、和声、旋律,助力音乐制作人加速创作过程。

❷音效设计:为电影、动画、游戏等媒体制作逼真的环境音效和特殊效果音。

❸游戏开发:为游戏角色、场景和动作添加音效,增强游戏的听觉体验和代入感。

❹广告配乐:快速匹配广告内容的背景音乐和音效,增强广告的吸引力和感染力。

❺音乐教育:辅助音乐教学,帮助学生更好地理解和掌握音乐理论和演奏技巧。

❻虚拟现实与增强现实:为虚拟环境生成匹配的音效,提升用户的沉浸感和交互体验。

Stable-Audio-Open工作原理

- 数据预处理:首先,将音频数据集进行预处理,以适应模型的输入要求。这可能包括音频的归一化、重采样或分割成适合模型处理的片段。

- 模型配置:通过JSON配置文件定义模型的超参数和训练设置。这些配置决定了模型的架构、学习率、批大小等关键训练参数。

- 模型初始化:根据配置文件初始化模型。如果是微调,将从预训练的检查点加载模型权重。

- 训练过程:

- 使用PyTorch Lightning框架,该框架提供易于使用的接口来设置训练循环,包括数据加载、模型训练和验证。

- 训练过程中,模型通过反向传播和梯度下降来优化权重,以最小化损失函数。

- 多GPU和多节点支持:利用PyTorch Lightning的分布式训练功能,Stable-audio-tools 可以在多个GPU和节点上并行训练模型,加速训练过程。

- 模型优化:在训练过程中,模型可能使用各种优化技术,如学习率调度、权重衰减、梯度累积等,以提高训练效率和模型性能。

- 注意力机制:特别是Flash Attention,这是一种高效的注意力机制,可以减少计算复杂度,加速模型的训练和推理。

- 模型评估:在训练过程中,定期评估模型的性能,使用验证集来监控模型的泛化能力。

- 模型保存和加载:训练完成后,保存模型的权重和配置,以便进行后续的推理或进一步的训练。

- 推理和生成:使用训练好的模型进行音频生成。用户可以提供条件信息,模型根据这些条件生成新的音频内容。

- 界面交互:通过Gradio界面,用户可以输入条件并实时看到生成的音频结果,提供了一个用户友好的测试和演示环境。

Stable-Audio-Open项目入口

- 官方网站:https://www.stableaudio.com/

- GitHub源码库:https://github.com/Stability-AI/stable-audio-tools

- Hugging Face Demo:https://huggingface.co/stabilityai/stable-audio-open-1.0

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号