Gemma 2简介

Gemma 2是Google最新发布的开源大型语言模型,包含90亿和270亿参数的版本,均提供基础和指令调优变体。基于DeepMind的Gemini技术,Gemma 2具有8192 Tokens的上下文理解能力,并通过采用滑动窗口注意力、Logit软上限、知识蒸馏和模型合并等先进技术,显著提升了性能。该模型在多种基准测试中展现了卓越的文本生成和理解能力,同时在Hugging Face Hub上开源,易于集成和使用,进一步推动了AI技术的普及和创新。

Gemma 2技术改进

❶注意力机制的创新:引入了局部-全局注意力的交错使用,即在模型的不同层中交替使用局部滑动窗口注意力和全局注意力,以提高对长距离依赖的捕捉能力。

❷知识蒸馏的应用:Gemma 2采用了知识蒸馏技术,代替了传统的下一个词预测训练方法。这种方法通过使用大型模型提供的下一个词的概率分布来训练小型模型,从而在训练步骤中为网络提供更丰富的信息。

❸模型架构的优化:Gemma 2模型采用了解码器仅变换器架构,具有更大的上下文长度和改进的非线性激活函数GeGLU。

❹参数和层的调整:不同规模的Gemma 2模型拥有不同的参数数量和层数,以适应不同规模的需求和性能优化。

❺高效的训练技术:使用了诸如ZeRO-3优化器状态分割技术和Pathways方法,以支持大规模模型训练。

❻模型和数据的分割:在训练过程中,模型和数据都进行了分割,以适应不同的硬件配置和提高计算效率。

❼安全性和鲁棒性:Gemma 2在设计时考虑了安全性和鲁棒性,包括数据过滤和后训练阶段的微调,以减少不期望的行为和提高模型的安全性。

Gemma 2性能优势

❶性能卓越::Gemma 2的27B版本在同类尺寸的模型中表现最为出色,甚至能够与体积是其两倍以上的模型相媲美。而9B版本的Gemma 2也在其尺寸类别中领先,超越了Llama 3的8B版本以及其他开放模型。

❷效率与成本优势显著:27B版本的Gemma 2设计用于在单个Google Cloud TPU主机、NVIDIA A100 80GB Tensor Core GPU或NVIDIA H100 Tensor Core GPU上以全精度高效运行推理,大幅降低成本,同时保持了高性能。

❸快速的跨硬件推理:Gemma 2针对各种硬件平台进行了优化,无论是游戏笔记本电脑、高端台式机还是基于云的设置,都能实现极速推理。

❹开放性与易用性:Gemma 2与原始的Gemma模型一样,采用商业友好的Gemma许可证,允许开发者和研究人员分享和商业化他们的创新成果。

❺框架兼容性广泛:Gemma 2与主要的AI框架兼容,如Hugging Face Transformers,以及通过Keras 3.0、vLLM、Gemma.cpp、Llama.cpp和Ollama与PyTorch和TensorFlow的原生兼容性,使得用户可以轻松地将❻其集成到现有的工具和工作流程中。此外,Gemma 2还针对NVIDIA TensorRT-LLM进行了优化,可在NVIDIA加速的基础设施上运行,或作为NVIDIA NIM推理微服务,未来还将针对NVIDIA的NeMo进行优化。

❼部署简便:从下个月开始,Google Cloud的客户将能够在Vertex AI上轻松部署和管理Gemma 2,进一步简化了AI模型的部署过程。

Gemma 2模型评估

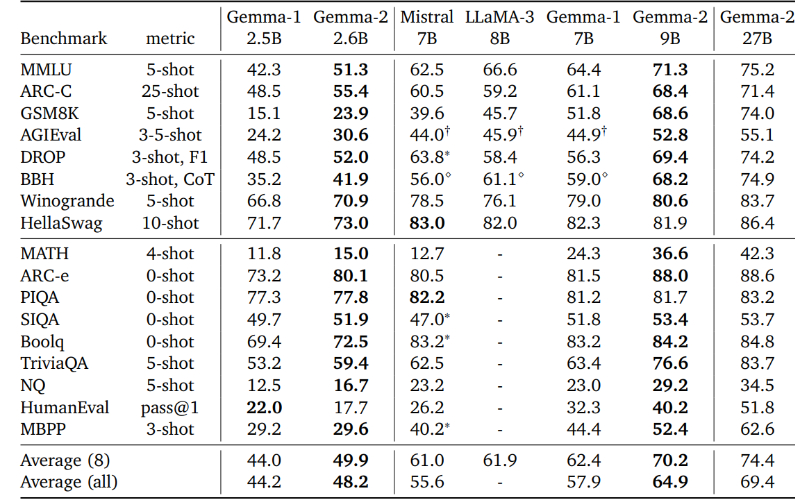

在对不同参数规模的模型进行比较时,研究者们特别关注了2.6B到9B参数的模型,以及他们自己的27B模型。他们选择了8个能够与LLaMA-3模型进行比较的基准测试,并在这8个基准上报告了平均性能。

此外,谷歌目前正在新的开源 LLM 排行榜基准上单独评估 Google Gemma 2,并将在今天晚些时候更新此部分。开源 LLM 排行榜:https://hf.co/spaces/HuggingFaceH4/open_llm_leaderboard

Gemma 2应用场景

❶文本生成:这些模型可用于生成创意文本格式,如诗歌、脚本、代码、营销文案和电子邮件草稿。

❷聊天机器人和对话式人工智能:为客户服务、虚拟助手或交互式应用程序提供强大的对话界面。

❸文本摘要:生成文本语料库、研究论文或报告的简洁摘要。

❹自然语言处理研究:这些模型可以作为研究人员试验 NLP 技术、开发算法和促进该领域进步的基础。

❺语言学习工具:支持交互式语言学习体验,帮助纠正语法或提供写作练习。

❻知识探索:通过生成摘要或回答有关特定主题的问题来帮助研究人员探索大量文本。

粤公网安备44011102483711号

粤公网安备44011102483711号