浦语灵笔IXC-2.5:支持长上下文输入和输出的多功能大视觉语言模型

浦语灵笔IXC-2.5简介

浦语灵笔IXC-2.5是由上海人工智能实验室联合香港中文大学、商汤科技集团和清华大学共同开发的一款多功能大型视觉语言模型。它具有长上下文输入和输出功能,可实现超高分辨率图像理解、细粒度视频理解、多回合多图像对话、网页生成和文章撰写等高级功能。IXC-2.5在28个基准测试中表现出色,超越了16个现有开源最先进模型,并在多个关键任务上与商业API如GPT-4V和Gemini Pro相媲美或紧随其后,展现了其在文本图像理解和创作应用方面的卓越能力。

浦语灵笔IXC-2.5主要功能

❶ 长上下文输入输出支持:IXC-2.5能够处理长达96K的上下文信息,适合需要广泛输入和输出的任务。

❷超高分辨率图像理解:模型增强了动态分辨率解决方案,支持任何比例的高分辨率图像。

❸细粒度视频理解:将视频视为由数十到数百帧组成的超高分辨率复合图像,通过密集采样和更高分辨率捕捉细节。

❹多轮多图像对话:支持自由形式的多轮多图像对话,实现与人类自然互动。

❺网页制作:根据文本图像指令,IXC-2.5可以创建网页,编写HTML、CSS和JavaScript源代码。

❻图文文章撰写:利用特别设计的链式思维(Chain-of-Thought)和直接偏好优化(Direct Preference Optimization)技术,提升写作内容的质量。

浦语灵笔IXC-2.5技术原理

❶多模态输入处理:IXC-2.5支持文本、单/多图像和视频等多种输入模式,采用统一的动态图像分割策略。

❷视觉编码器:使用分辨率为560×560的ViT视觉编码器,每个子图像有400个标记,适应不同分辨率和纵横比的图像。

❸位置编码外推(RoPE):通过位置编码外推技术,IXC-2.5能够扩展其上下文窗口,处理更长的输入和输出。

❹预训练与微调:在预训练阶段冻结大型语言模型(LLM),微调视觉编码器和部分LoRA以对齐视觉标记。在监督微调阶段,使用特定数据集进行进一步训练。

❺网页生成能力:IXC-2.5通过训练,能够根据视觉截图、自由形式指令或简历文档自动构建网页。

❻文章撰写能力:通过监督微调、奖励建模、偏好数据收集和直接偏好优化(DPO)对齐,提高生成高质量图文文章的能力。

浦语灵笔IXC-2.5应用场景

❶ 自由形式文本图像对话:与用户进行包含图像的多轮对话。

❷图像识别与分析:识别和分析图像内容,提供详细信息。

❸视频内容理解:解析视频内容,进行视频问答或总结。

❹网页设计:根据用户指令或草图自动生成网页代码。

❺图文文章创作:结合图像和文本创作文章或报告。

❻教育辅助:辅助教师或学生在教育内容的创作和理解。

❼数据可视化解释:解释图表和数据可视化内容。

❽客户服务:在客户服务中提供图像和文本相关的帮助和解答。

❾内容审核:自动化图像和文本内容的审核和管理。

❿多语言翻译:结合图像上下文进行更准确的多语言翻译。

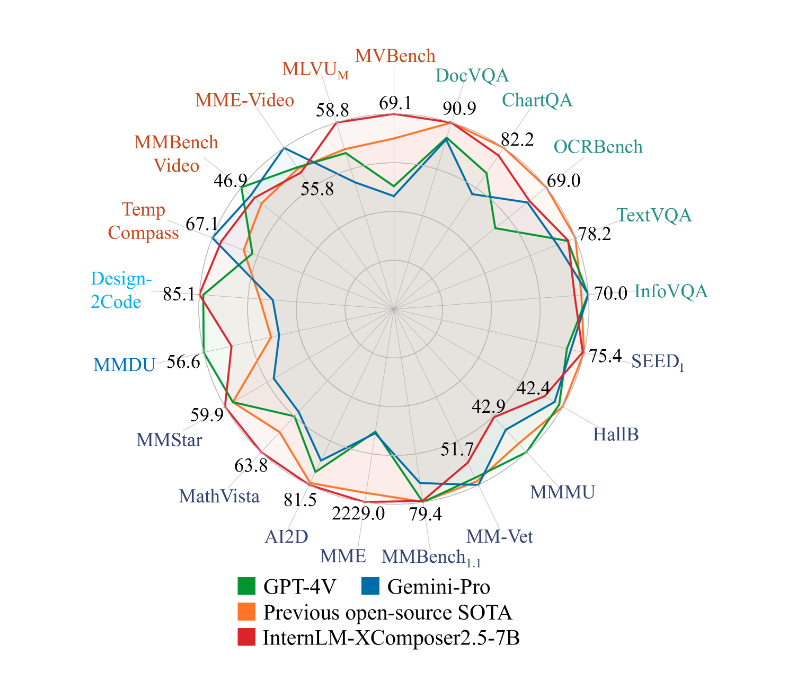

LVLM 基准测试结果

❶视频理解:IXC-2.5在视频理解任务上表现出色,例如在MVBench、MLVU、MME-Video和MMBench-Video等基准测试中,与现有的开源模型相比,IXC-2.5在其中的四个基准测试中取得了更好的性能,并且与闭源API的性能相当。

❷结构化高分辨率图像理解:IXC-2.5在处理结构化高分辨率图像方面也展现了强大的能力,在DocVQA、ChartQA、InfographicVQA、TextVQA、OCRBench、DeepForm、WikiTableQuestion (WTQ)、Visual MRC和TabFact等基准测试中,IXC-2.5的性能与大型开源LVLMs和闭源API相当。

❸多轮多图像对话:在MMDU基准测试中,IXC-2.5展示了其在多轮多图像对话任务上的优势,性能显著优于先前的开源SOTA模型。

❹通用视觉问答:IXC-2.5在通用视觉问答基准测试中,如MMStar、RealWorldQA、MathVista、MMMU、AI2D、MME、MMBench (MMB)、MMBench-Chinese (MMBCN)、MMBench-v1.1 (MMBv1.1)、SEED-Bench Image Part (SEEDI)、MM-Vet和HallusionBench (HallB)等,表现出与当前大型开源LVLMs和闭源API相媲美的性能。

❺网页制作:在Design2Code基准测试中,IXC-2.5在将视觉设计转换为代码实现方面超越了GPT-4V,显示出其在这一领域的潜力。

浦语灵笔IXC-2.5入口

- GitHub代码库:https://github.com/InternLM/InternLM-XComposer

- arXiv研究论文:https://arxiv.org/abs/2407.03320

粤公网安备44011102483711号

粤公网安备44011102483711号