Mistral NeMo:Mistral AI与英伟达合作推出的一款具有120亿参数的大型语言模型

Mistral NeMo模型简介

Mistral NeMo是由Mistral AI与NVIDIA合作推出的一款具有120亿参数的大型语言模型,它以高达128k tokens的上下文窗口和出色的推理、世界知识和代码准确性而著称。专为多语言环境设计,Mistral NeMo在英语、法语、德语等多种语言上表现卓越,并通过其高效的Tekken分词器,优化了对100多种语言的文本和源代码压缩。此外,它还支持量化感知训练,允许在不损失性能的情况下进行FP8推理,并通过开源Apache 2.0许可,鼓励研究人员和企业的广泛采用。

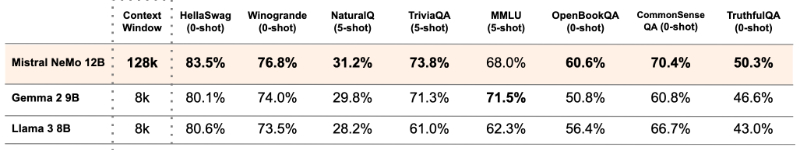

Mistral NeMo模型性能

Mistral NeMo 经过了先进的指令微调和对齐阶段,与 Mistral 7B 相比,在遵循精确指令、推理、处理多轮对话和代码生成方面表现更佳。此外,Mistral AI 还提供了与 Gemma 2 9B 和 Llama 3 8B 两个开源预训练模型的性能比较数据。

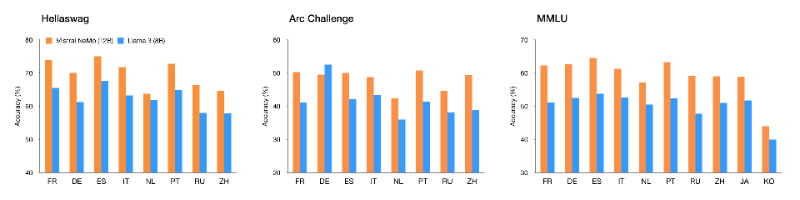

Mistral NeMo模型支持多语言

该模型专为全球多语言应用而设计。它经过函数调用训练,具有较大的上下文窗口,尤其擅长英语、法语、德语、西班牙语、意大利语、葡萄牙语、中文、日语、韩语、阿拉伯语和印地语。这是将前沿人工智能模型带给所有人的新的一步,适用于构成人类文化的所有语言。

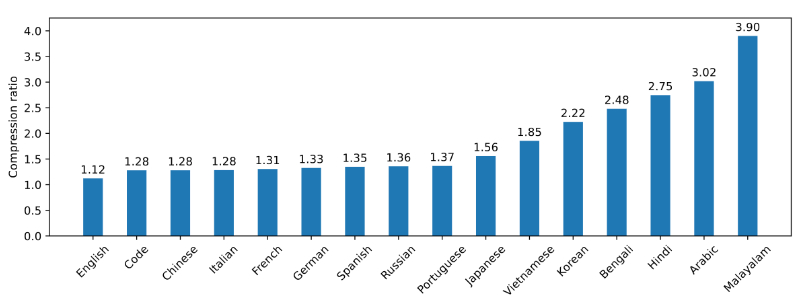

Mistral NeMo更高效的标记器

Mistral NeMo 使用基于 Tiktoken 的新标记器 Tekken,该标记器已针对 100 多种语言进行训练,并且比以前的 Mistral 模型中使用的 SentencePiece 标记器更有效地压缩自然语言文本和源代码。具体而言,它在压缩源代码、中文、意大利语、法语、德语、西班牙语和俄语方面的效率提高了约 30%。它在压缩韩语和阿拉伯语方面的效率也分别提高了 2 倍和 3 倍。与 Llama 3 标记器相比,Tekken 在压缩大约 85% 的所有语言的文本方面表现更为出色。

Mistral NeMo官方入口

Mistral AI 和 NVIDIA 的合作成果 Mistral NeMo 模型的权重现已在 HuggingFace 平台上提供,包括Mistral-Nemo-Base-2407和Mistral-Nemo-Instruct-2407版本。开发者可以使用 mistral-inference 工具开始试验 Mistral NeMo,并使用 mistral-finetune 进行调整。对于使用 Mistral 平台的用户,可以通过 open-mistral-nemo 访问该模型。此外,Mistral NeMo 也被封装在 NVIDIA NIM 推理微服务容器中,可通过 http://ai.nvidia.com 获取。更多信息参考官方介绍:https://mistral.ai/news/mistral-nemo/

粤公网安备44011102483711号

粤公网安备44011102483711号