Diffree:通过文本描述智能地在图像中添加新对象

Diffree简介

Diffree是由厦门大学多媒体可信感知与高效计算教育部重点实验室联合上海人工智能实验室OpenGVLab和香港大学的研究团队共同开发的一种创新图像修复技术。这项技术能够仅通过文本描述,智能地在图像中添加新对象,同时确保与现有背景在视觉风格和空间布局上的无缝融合。Diffree的突破之处在于它无需额外的遮罩输入,就能实现高成功率的对象添加,极大地简化了图像编辑过程,并为广告创作、虚拟试穿和装修可视化等领域带来了新的应用可能。

Diffree主要功能

- 文本引导的对象添加:Diffree能够根据用户提供的文本描述,在图像中添加相应的新对象。

- 背景保持一致性:在添加新对象的过程中,Diffree能够保持原始图像的背景,确保新旧元素在视觉上的和谐统一。

- 无需手动遮罩:与需要用户指定遮罩的图像编辑方法不同,Diffree不需要用户手动绘制遮罩,减少了操作复杂性。

- 迭代对象添加:Diffree支持在单张图像上进行多次对象添加,每次添加都能维持背景的一致性。

- 高成功率:Diffree在实验中显示出高成功率,能够有效地完成对象添加任务。

Diffree技术原理

- 文本到图像(T2I)模型:Diffree基于Stable Diffusion等扩散模型,将文本描述转化为图像内容。

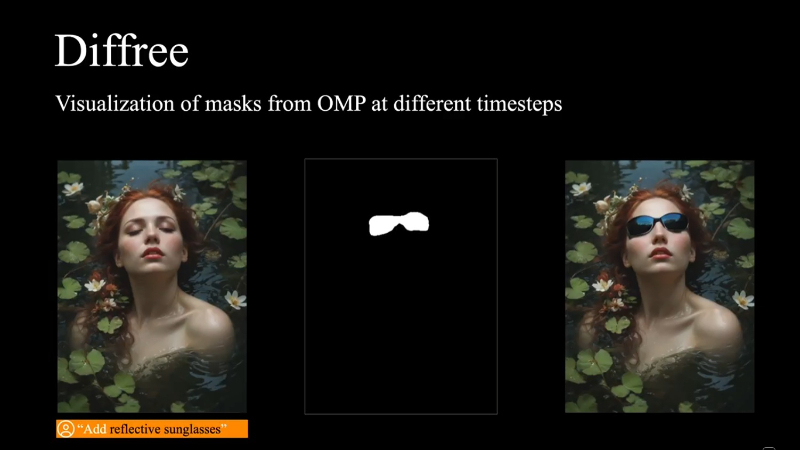

- 对象遮罩预测模块(OMP):Diffree集成了一个额外的模块,用于预测新添加对象的理想遮罩区域。

- 数据集OABench:为了训练模型,研究团队创建了一个合成数据集,包含原始图像、遮罩和文本描述,用于训练Diffree理解对象与背景的关系。

- 扩散和逆扩散过程:Diffree使用扩散模型的正向和逆向过程,通过逐步去除噪声来生成图像。

- 特征融合:Diffree结合了图像和文本的特征,通过CLIP文本编码器和图像编码器的输出,引导生成过程。

- 损失函数优化:模型通过最小化损失函数来训练OMP模块和扩散模型,确保生成的对象与文本描述相匹配。

- 评估指标:Diffree使用一系列评估指标,包括背景一致性、对象位置合理性等,来量化图像编辑的质量。

- 兼容性:Diffree可以与其他图像编辑工具结合使用,扩展其功能,如与AnyDoor结合进行特定区域的对象添加。

Diffree应用场景

- 广告创作:在广告图像中添加产品或元素,增强视觉效果。

- 虚拟试穿:在用户照片中添加衣物或配饰,提供试穿体验。

- 装修可视化:在室内场景中添加家具或装饰品,展示装修效果。

- 游戏开发:快速生成或修改游戏资产,如角色或道具。

- 电影制作:在后期制作中添加或修改场景元素,节省成本。

- 社交媒体:用户在社交媒体上分享时,个性化编辑图片。

Diffree项目入口

- 官方项目主页:https://opengvlab.github.io/Diffree/

- GitHub代码库:https://github.com/OpenGVLab/Diffree

- arXiv研究论文:https://arxiv.org/pdf/2407.16982

- Hugging Face在线体验:https://huggingface.co/spaces/LiruiZhao/Diffree

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号