EmoTalk3D:情感可控3D会说话头部模型

EmoTalk3D项目简介

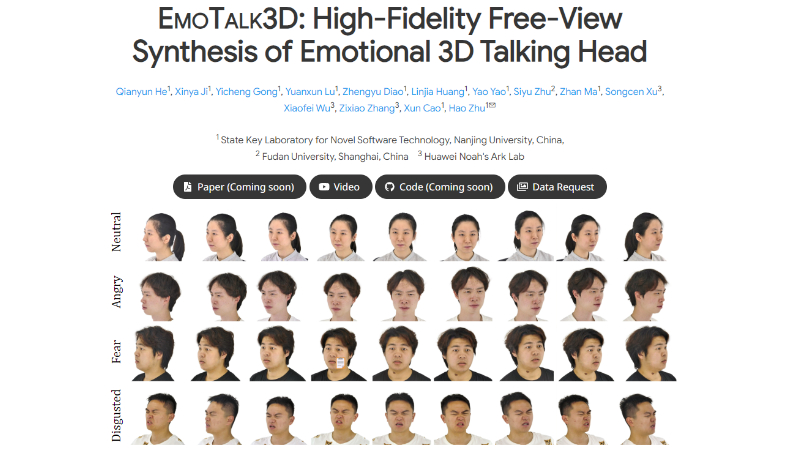

EmoTalk3D 是由南京大学新型软件技术国家重点实验室联合复旦大学和华为诺亚方舟实验室共同开发的一项先进技术。这项技术通过一个创新的‘Speech-to-Geometry-to-Appearance’框架,能够合成具有高保真度和可控情感的3D会说话头部模型。它通过精确的唇部同步和渲染质量,以及对情感表达的细致捕捉,极大地提升了虚拟角色的真实感和交流能力。EmoTalk3D 的研究成果不仅包括了算法的创新,还发布了与之配套的 EmoTalk3D 数据集,为未来在情感可控3D会说话头部模型的研究提供了坚实的基础。

EmoTalk3D主要功能

- 高保真3D头部合成:能够根据语音信号生成高分辨率、逼真的3D会说话头部动画。

- 情感控制:用户可以控制生成的3D头部模型表达不同的情感,如愤怒、快乐、悲伤等。

- 多视角渲染:支持在宽范围的视角下渲染3D头部模型,提供更丰富的视觉体验。

- 唇部同步增强:提高了唇部动作与语音同步的准确性,使得动画更加自然。

- 面部细节捕捉:能够捕捉并渲染面部的微妙表情和动态细节,如皱纹和肌肉运动。

EmoTalk3D技术原理

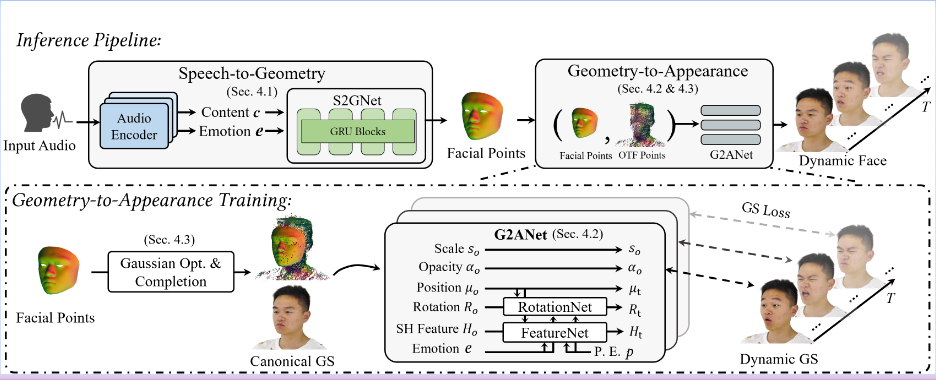

- Speech-to-Geometry-to-Appearance框架:首先将语音信号映射到3D几何形态,然后再从几何形态合成3D头部的外观。

- Speech-to-Geometry Network (S2GNet):使用音频特征预测出精确的4D点云,恢复表情和唇部动作。

- 4D Gaussian模型:基于预测的4D点建立模型,有效表示面部外观,并将外观分解为静态和动态高斯模型。

- Geometry-to-Appearance Network (G2ANet):学习多视角视频中的动态外观,并渲染自由视角的头部动画。

- 情感引导的4D预测网络:设计用于实现对3D会说话头部生成的情感控制,根据情感标签调节模型的输出。

- EmoTalk3D数据集:一个带有情感注释的多视角头部数据集,为训练模型提供了丰富的样本。

- 3D Gaussian Splatting:一种用于实时辐射场渲染的技术,用于模拟动态面部运动并实现高视觉质量。

EmoTalk3D应用场景

- 虚拟助手:作为智能设备的虚拟面孔,提供更加自然和情感化的交互体验。

- 电影和游戏制作:用于生成具有高度真实感的角色面部动画,增强视觉和情感表达。

- 远程会议:在视频会议中使用,提供更加生动和富有表现力的虚拟参与者形象。

- 教育和培训:作为虚拟教师或培训师,提供互动式学习体验。

- 客户服务:在自动客服系统中,以更人性化的方式与客户进行交流。

- 社交媒体和娱乐:用于创建个性化的虚拟形象,用于直播、短视频或在线表演。

EmoTalk3D项目入口

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号