UniBench:Meta等推出的视觉语言模型的系统性评估工具

UniBench简介

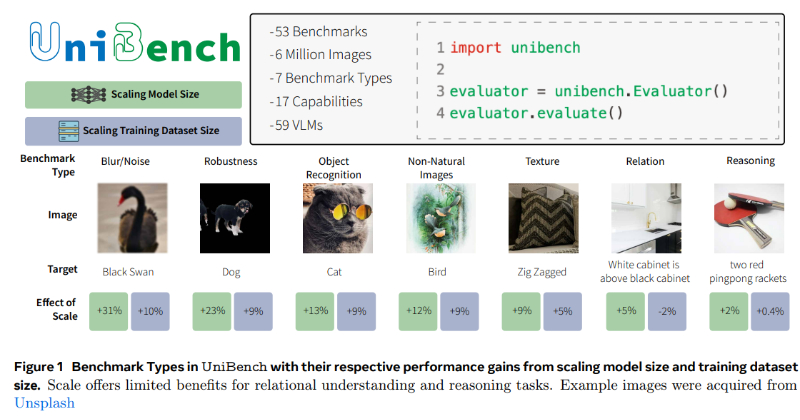

UniBench 是由 Meta、Univ Gustave Eiffel、CNRS 和 LIGM 联合开发的一项创新工具,旨在为视觉-语言模型(VLM)提供一个统一的评估平台。它集成了50多个基准测试,全面覆盖了从物体识别到空间意识、计数等多样化的能力范畴。UniBench 的开发团队通过这一工具,为研究人员提供了一个易于使用的系统,以衡量和理解 VLM 在不同方面的进步,同时指出了在推理和关系理解方面的性能提升并不总是随着模型规模的增加而提高,强调了数据质量和定制学习目标的重要性。

UniBench主要功能

- 统一的评估框架:UniBench提供了一个综合的评估系统,可以对视觉-语言模型(VLM)在多种任务上的性能进行全面测试。

- 多基准测试集成:集成了50多个VLM基准测试,覆盖了从标准物体识别到空间理解、计数、地理多样性等不同能力。

- 性能比较:允许研究人员比较不同VLM在统一的评估标准下的性能,包括模型规模、训练数据集大小和学习目标。

- 能力分类:将基准测试分为七种类型和十七种更细粒度的能力,以快速识别模型的优势和劣势。

- 易用性:提供了易于运行的代码库,使得研究人员和实践者可以快速评估VLMs。

- 快速评估:提供了一个精简的基准测试集合,可以在单个GPU上在5分钟内完成评估。

UniBench技术原理

- 标准化协议:UniBench使用标准化的评估协议来测试VLMs在各种基准测试上的性能。

- 零样本分类:对于某些基准测试,UniBench采用零样本分类的方法,通过比较类别标签的表示与图像表示来预测类别。

- 关系和逻辑推理:对于测试模型之间关系的基准测试,UniBench通过对比正确和错误的描述与图像表示来进行评估。

- 数据集和模型多样性:评估了不同规模、架构和学习目标的59个公开可用的VLM,包括从小型数据集到高达128亿样本的大型数据集。

- 性能提升分析:UniBench分析了模型规模和训练数据集规模对性能的影响,特别是在视觉关系和推理任务上。

- 定制化和数据质量:发现定制化的学习目标和高质量的训练数据对于提升模型在关系和推理任务上的性能至关重要。

- 代码库和工具:提供了一个代码库,包括50多个基准测试和对59个VLM的比较,以及可以在单个GPU上快速运行的代表性基准测试集合。

UniBench应用场景

- 学术研究:为研究人员提供一个标准化平台,以系统地评估和比较不同VLMs的性能。

- 模型开发:帮助开发者理解其VLM在特定任务上的优势和局限,指导模型设计和优化。

- 教育领域:作为教学工具,帮助学生理解视觉-语言模型的工作原理和评估方法。

- 工业应用:在自动化图像分析、智能监控等场景中,评估和选择最合适的VLM以满足特定需求。

- 跨模态搜索:在需要结合图像和文本进行搜索的应用中,评估VLMs的搜索准确性和效率。

- 辅助决策:为企业提供数据支持,帮助它们在部署视觉-语言模型时做出更明智的决策。

UniBench项目入口

- GitHub代码库:https://github.com/facebookresearch/unibench

- arXiv研究论文:https://arxiv.org/abs/2408.04810

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号