MagicPose:基于扩散模型的2D人体姿态与表情重定向

MagicPose简介

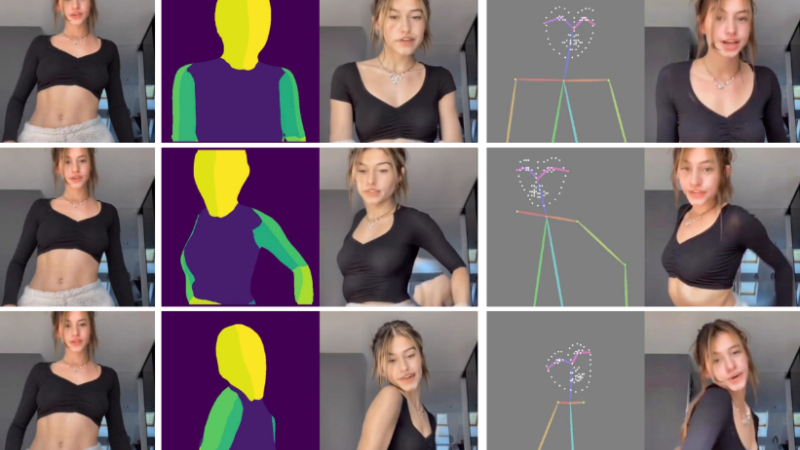

MagicPose是由美国南加州大学与字节跳动公司联合开发的创新模型,它利用基于扩散的机制,实现了对2D人物姿态和面部表情的精准重定向。这项技术能够在不改变人物身份特征的前提下,控制生成图像中的人物动作和表情,展现出高度逼真的视觉效果。MagicPose的设计使其可以作为插件模块,轻松集成到现有的Stable Diffusion模型中,提供了一种易于使用且功能强大的人物图像编辑工具。

MagicPose主要功能

- 身份保持:在生成新图像时,保持人物的身份特征,如面部特征和身体特征不变。

- 姿态控制:允许用户控制人物的姿态,包括身体姿势和面部表情,以适应不同的需求。

- 无需微调:对于未见过的人体身份和复杂姿态,MagicPose能够很好地泛化,无需额外的微调。

- 插件模块:作为一个插件模块,可以轻松集成到Stable Diffusion等现有的图像生成模型中。

MagicPose技术原理

- 两阶段训练策略:首先预训练外观控制模块,然后学习外观解耦的姿态控制。

- 外观控制模型:通过多源注意力模块,从参考图像提供外观指导,控制生成图像的面部属性和身体特征。

- 姿态控制网络(Pose ControlNet):提供姿势和表情的指导,确保生成的图像符合目标姿态和表情。

- 身份意识扩散:利用图像扩散模型的先验知识,实现对不同人体身份和姿态的泛化。

- 多源自注意力模块:通过连接外观控制模型和Stable Diffusion的自注意力层,实现外观信息的空间传递。

- 稳定性和灵活性:通过任务特定的参数引入,增强了零样本注意力控制的稳定性,并提供了更灵活的信息交换能力。

- 数据增强:在训练过程中使用数据增强技术,如随机遮罩面部标志和手部姿势,以增强模型对不完整姿势估计的鲁棒性。

MagicPose应用场景

- 虚拟试衣:用户可以生成自己穿着不同服装的图像,用于在线购物试衣体验。

- 社交媒体内容创作:用户可以创作具有特定表情和姿态的个性化图片或动画,用于社交媒体分享。

- 游戏和动画制作:为游戏角色或动画人物设计逼真的动作和表情,提高视觉体验。

- 电影和视频制作:在后期制作中,用于生成或修改角色的动作和表情,节省拍摄成本。

- 虚拟现实(VR)体验:在VR环境中,为用户或虚拟角色生成逼真的姿态和表情,增强沉浸感。

- 教育和培训:在模拟训练中,生成具有教育意义的姿态和表情,用于非语言沟通教学。

MagicPose项目入口

-

GitHub代码库:https://github.com/Boese0601/MagicDance

-

arXiv技术论文:https://arxiv.org/pdf/2311.12052

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号