FancyVideo:跨帧文本引导的动态一致视频生成模型

FancyVideo简介

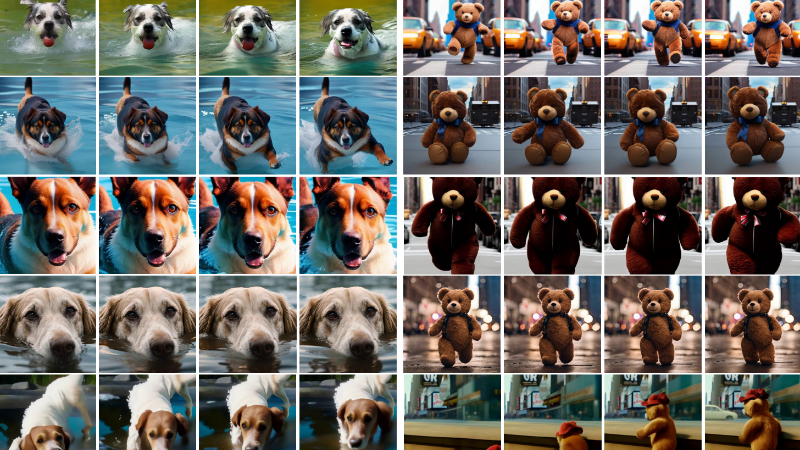

FancyVideo 是由360和中山大学共同开发的一款创新视频生成模型。它通过引入跨帧文本引导模块(Cross-frame Textual Guidance Module, CTGM),有效解决了在人工智能领域合成动态丰富且时间上连贯视频的挑战。该模型特别擅长处理长时间视频的生成,能够在保持文本提示中的时间逻辑的同时,生成具有连贯动作的视频。FancyVideo在EvalCrafter基准测试中取得了最先进的文本到视频(T2V)生成结果,展示了其在动态视频合成领域的突破性进展。

FancyVideo主要功能

- 动态视频生成:能够根据文本提示生成具有丰富动态效果的视频。

- 时间连贯性:确保视频在时间轴上的连贯性,避免运动不自然或跳跃。

- 高质量视频输出:在EvalCrafter等基准测试中达到最先进的视频生成质量。

- 多帧视频处理:支持生成多帧视频,增强视频的细节和流畅性。

- 跨帧文本引导:通过文本引导跨多个帧生成视频,提高视频的动态范围和一致性。

FancyVideo技术原理

- Cross-frame Textual Guidance Module (CTGM):一个核心组件,用于改善现有文本控制机制,通过跨帧文本引导来增强视频生成。

- Temporal Information Injector (TII):在文本条件中注入来自潜在特征的特定帧信息,生成跨帧文本条件。

- Temporal Affinity Refiner (TAR):沿着时间维度细化跨帧文本条件和潜在特征之间的相关性矩阵,增强文本引导的时间逻辑。

- Temporal Feature Booster (TFB):提升潜在特征的时间一致性,确保视频帧之间的平滑过渡和连贯性。

- 空间交叉注意力机制:在文本条件和潜在特征之间实现空间交叉注意力,用于文本控制生成。

- 潜在扩散模型 (Latent Diffusion Models, LDMs):使用变分自编码器(Variational Autoencoder, VAE)的编码器将图像压缩成潜在代码,并通过在潜在代码上执行正向和逆向扩散过程来学习数据分布。

- 零终端信噪比噪声计划:解决测试和训练阶段信噪比差异的问题,提高生成视频的质量。

- 模型架构:采用伪3D UNet结构,整合了冻结的空间块、CTGM和时间注意力块,以处理输入的噪声潜在特征、掩码指示器和图像指示器。

FancyVideo应用场景

- 电影和视频制作:用于生成特效场景或概念验证视频,加快前期制作流程。

- 虚拟现实(VR)内容创建:为虚拟现实体验提供动态且连贯的视频背景或场景。

- 游戏开发:生成游戏内动画或预告片,增强视觉体验。

- 广告和营销:创造吸引人的视频广告,以独特的方式展示产品或服务。

- 社交媒体内容:用户可以生成个性化的视频内容,用于社交媒体分享。

- 教育和培训:制作教学视频,通过动态演示帮助解释复杂概念。

FancyVideo项目入口

- GitHub代码库:https://github.com/360CVGroup/FancyVideo

- arXiv技术论文:https://arxiv.org/pdf/2408.08189

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号