Phi-3.5:微软最新推出的系列AI模型,包含三个模型

Phi-3.5简介

Phi-3.5是微软最新推出的系列AI模型,Phi-3.5系列包括三个模型:Phi-3.5-mini-instruct、Phi-3.5-MoE-instruct和Phi-3.5-vision-instruct,分别拥有38.2 亿、 419 亿和41.5亿参数,针对不同任务设计,如基本推理、复杂推理和视觉分析。这些模型在第三方基准测试中展现了接近最先进的性能,甚至在某些情况下超过了其他知名AI模型。它们在Hugging Face平台上以微软品牌的MIT许可证提供,允许开发者自由下载、使用和定制,且无商业使用和修改的限制。

Phi-3.5-mini-instruct介绍

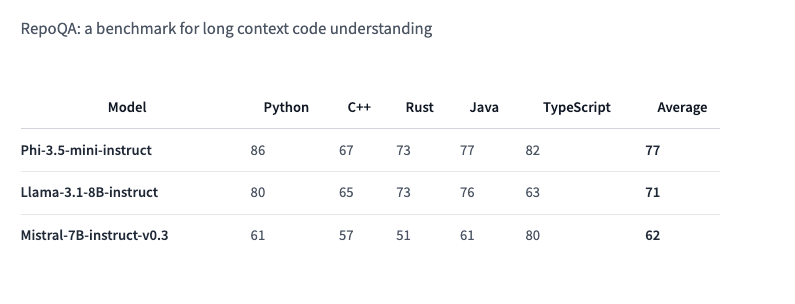

Phi-3.5 Mini Instruct是一款拥有38.2亿参数的轻量级AI模型,专为指令遵循和支持128k token 上下文长度而设计,适合在内存或计算受限的环境中进行代码生成、数学问题解决和基于逻辑的推理任务。尽管体积小巧,它在多语言和多轮对话任务中表现出色,性能接近最先进水平,并在衡量”长上下文代码理解”的RepoQA基准测试中超越了其他类似大小的模型。

Phi-3.5-MoE-instruct介绍

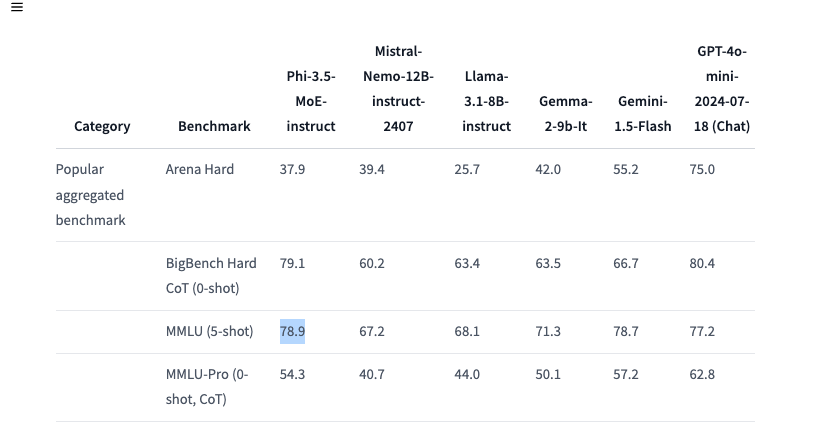

Phi-3.5 MoE模型是该公司推出的首款采用混合专家(MoE)架构的模型,通过结合多种不同专长的模型来处理不同任务。该模型拥有419亿个活跃参数并支持128k token 的上下文长度,为高要求的应用提供可扩展的AI性能。Phi-3.5 MoE在代码、数学和多语言理解等推理任务上表现出色,并在包括RepoQA在内的特定基准测试中经常超越更大的模型。此外,它还在 STEM、人文学科、社会科学等学科、不同专业水平的 5 次 MMLU(大规模多任务语言理解)测试中超过了 GPT-4o mini。MoE 模型独特的架构使其在处理跨多种语言的复杂 AI 任务时能够保持高效性。

Phi-3.5-vision-instruct介绍

Phi-3.5 Vision Instruct模型是Phi-3.5系列的第三款, 拥有 41.5 亿参数。它结合了文本和图像处理能力,特别适合执行一般图像理解、光学字符识别、图表和表格理解以及视频摘要等多模态任务。与系列中的其他模型一样,Vision Instruct支持128k token的上下文长度,能够处理复杂的多帧视觉任务。微软强调,该模型是使用合成和筛选过的公开可用数据集进行训练的,专注于高质量、推理密集型的数据。

Phi-3.5项目入口

- GitHub代码库:https://github.com/microsoft/Phi-3CookBook

- Phi-3.5-mini-instruct 模型:https://huggingface.co/microsoft/Phi-3.5-mini-instruct

- Phi-3.5-MoE-instruct 模型:https://huggingface.co/microsoft/Phi-3.5-MoE-instruct

- Phi-3.5-vision-instruct 模型:https://huggingface.co/microsoft/Phi-3.5-vision-instruct

粤公网安备44011102483711号

粤公网安备44011102483711号