LongVILA:提升长视频理解的多模态视觉语言模型

LongVILA简介

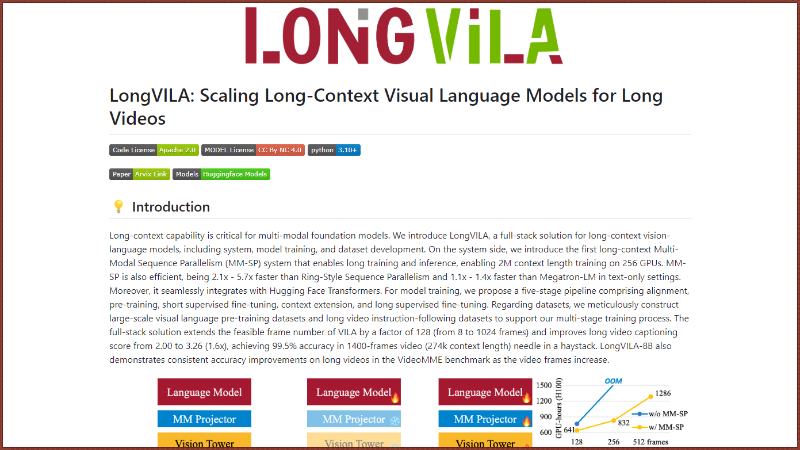

LongVILA是由英伟达、MIT、UC 伯克利、得克萨斯大学奥斯汀分校的联合研究团队开发的一种先进的多模态视觉语言模型。它专为长视频理解而设计,通过算法和系统架构的共同优化,实现了对长时间视频内容的深入分析和理解。LongVILA能够处理长达1024帧的视频,在长视频字幕生成和细节识别任务中表现出色,大幅提升了视频处理的准确性和效率。这项技术的开发,标志着在长视频理解和自动字幕生成领域迈出了重要一步。

LongVILA主要功能

- 长视频理解:LongVILA能够处理和理解长达1024帧的视频内容,适用于需要分析长时间序列的应用场景。

- 长视频字幕生成:模型能够自动为长视频生成准确的字幕,提高了视频内容的可访问性和搜索性。

- 细节识别:在进行视频内容分析时,LongVILA能够识别并记忆视频中的细节信息,即使这些信息在视频的早期阶段出现。

- 多模态输入处理:LongVILA支持多种模态的输入信号,如图像、文本和视频,使其能够进行更丰富的交互和分析。

LongVILA技术原理

- 长上下文扩展:LongVILA通过增加模型的上下文长度,使其能够处理更长的视频序列。

- 多模态序列并行性(MM-SP):这是一种系统级创新,允许模型在多个GPU上高效并行地训练和推理长视频数据。

- 五阶段训练流程:包括多模态对齐、大规模预训练、短监督微调、长上下文扩展和长监督微调,逐步提升模型对长视频内容的处理能力。

- 高效的内存和计算资源管理:通过优化数据和模型的分布式处理,LongVILA能够在有限的硬件资源上实现高性能训练。

- 上下文并行性与张量并行性的结合:LongVILA利用这两种并行性技术进一步提高了模型的扩展性和训练效率。

- 长视频数据集构建:研究团队构建了专门的长视频数据集,用于模型的训练和评估,确保模型能够处理实际的长视频内容。

LongVILA应用场景

- 视频内容监控:LongVILA可以分析监控视频,识别异常行为或事件,用于安全监控系统。

- 社交媒体分析:在社交媒体平台上,LongVILA能够理解和分析用户分享的长视频内容,提供内容审核和趋势分析。

- 教育和培训:LongVILA可以自动生成教育视频的字幕和摘要,辅助学习和知识传递。

- 视频搜索优化:通过理解视频内容,LongVILA能够改善视频搜索引擎,提供更准确的搜索结果。

- 自动驾驶车辆:LongVILA可以分析道路监控视频,辅助自动驾驶车辆理解交通情况,提高行车安全。

- 体育赛事分析:LongVILA能够自动分析体育赛事视频,提供比赛摘要、精彩瞬间识别和战术分析。

LongVILA项目入口

- GitHub源码库:https://github.com/NVlabs/VILA/blob/main/LongVILA.md

- arXiv研究论文:https://arxiv.org/abs/2408.10188

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号