DistriFusion:显著减少使用扩散模型生成高分辨率图像所需的时间

DistriFusion简介

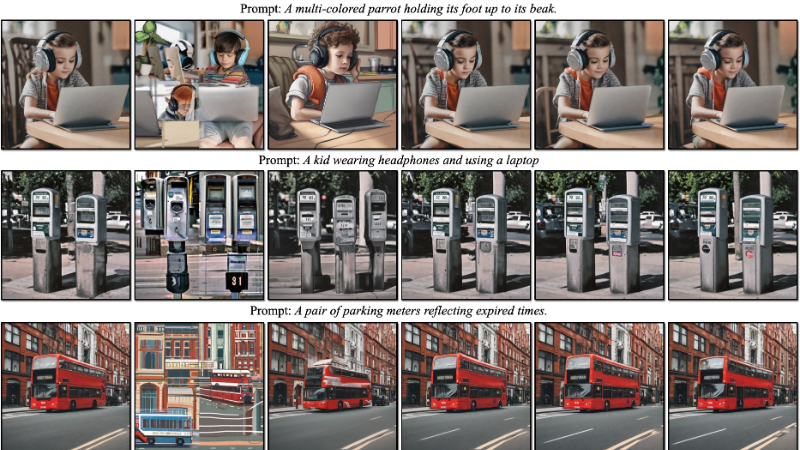

DistriFusion是由MIT、普林斯顿大学、Lepton AI和NVIDIA的联合研究团队开发的一种创新算法,旨在通过在多个GPU上实现分布式并行推理,显著加速高分辨率扩散模型的图像生成过程。该算法通过将图像分割成多个区块并分配给不同的GPU处理,同时巧妙地利用前一步骤的计算结果来提供当前步骤所需的上下文信息,从而减少了通信开销并保持了图像质量。DistriFusion不仅大幅提升了生成图像的速度,而且无需重新训练模型,为AI内容创造领域带来了效率上的飞跃。

DistriFusion主要功能

- 加速图像生成:DistriFusion能够显著减少使用扩散模型生成高分辨率图像所需的时间。

- 多GPU并行处理:通过在多个GPU上分配计算任务,实现图像生成过程的并行化。

- 保持图像质量:在加速图像生成的同时,不牺牲图像的质量和细节。

- 无需重新训练模型:作为一种训练无关的算法,DistriFusion可以直接应用于现有的预训练扩散模型。

DistriFusion技术原理

- 分片处理:DistriFusion将模型输入的图像分割成多个小的区块(patches),每个区块由不同的GPU独立处理。

- 位移块并行性(Displaced Patch Parallelism):利用扩散过程的时间序列特性,通过重用前一时间步的预计算特征图来为当前步骤提供上下文信息。

- 异步通信:支持异步通信机制,将通信开销隐藏在计算流程中,从而减少等待时间。

- 稀疏计算:仅在分配给特定GPU的区域上执行卷积和注意力层的操作,减少了每个设备上的计算量。

- 修正的异步组归一化(Corrected Asynchronous GroupNorm):为了保持图像质量,DistriFusion引入了一种修正项来调整旧的统计数据,以近似当前步骤的全局均值和方差。

- 预热步骤(Warm-up steps):在算法的初始阶段使用标准同步块并行性进行几次迭代,作为预热阶段,以提高图像质量。

DistriFusion应用场景

- 高质量图像合成:用于生成高分辨率且视觉逼真的图像,适用于艺术创作和娱乐产业。

- 虚拟现实内容创建:为虚拟现实环境快速生成精细的3D模型和纹理。

- 电影和游戏制作:在电影视觉效果和电子游戏中生成逼真的背景和角色。

- 图像编辑和增强:提供快速的图像编辑工具,帮助设计师和摄影师优化作品。

- 自动化设计:在广告和平面设计中快速生成或修改图像素材。

- 数据增强:在机器学习中用于生成额外的训练数据,提高模型的泛化能力。

DistriFusion项目入口

-

arXiv技术论文:https://arxiv.org/pdf/2402.19481

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号