MUMU:一款创新的多模态图像生成模型

MUMU简介

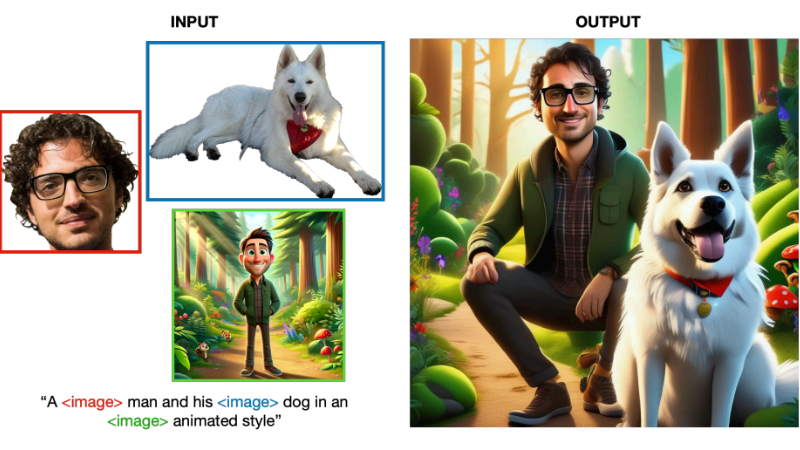

MUMU是由Sutter Hill Ventures的研究团队开发的一款创新的多模态图像生成模型,它能够通过结合文本和图像输入生成新的图像。该模型通过自举方法构建训练数据集,利用视觉-语言模型编码器和扩散解码器,实现从多模态提示中学习并生成连贯的图像输出。MUMU展现了在风格迁移和角色一致性等任务上的潜力,为图像生成领域带来了新的可能性。尽管在细节一致性方面还有待提高,MUMU的研究成果已经显示出多模态模型在控制图像生成方面的广阔前景。

MUMU主要功能

- 多模态图像生成:MUMU能够根据文本和图像的组合提示生成新的图像,这使得用户可以更精确地指定他们想要生成的图像内容。

- 风格迁移:模型能够将现实人物图像转换成卡通风格,或者将一个图像中的对象与另一个图像的风格相融合。

- 角色一致性:在生成包含特定角色的图像时,MUMU能够保持角色的一致性,即使在不同的图像和风格中也能识别和复现角色特征。

- 细节保留:尽管存在挑战,MUMU在生成图像时能够较好地保留输入图像的重要细节。

MUMU技术原理

- 自举数据集构建:通过从现有的文本-图像数据中提取与图像标题中单词相对应的图像裁剪,构建用于训练的多模态数据集。

- 视觉-语言模型编码器:使用视觉-语言模型(如Idefics2)替代传统的文本编码器(如CLIP),以处理图像输入并生成隐藏状态。

- 扩散解码器:采用扩散模型作为解码器,通过迭代去噪过程生成图像。

- 跨模态理解:模型通过训练学习理解不同模态(文本和图像)之间的关系,并能够将这些理解应用于图像生成过程。

- 细节和风格的融合:尽管主要在相同图像的裁剪上训练,MUMU能够将来自不同图像的输入融合成具有一致风格和细节的输出。

- 小批量精细调整:在训练过程中,MUMU通过小批量的精细调整来提高图像质量,尤其是在处理人脸等小细节时。

- 生成控制:MUMU允许用户通过多模态提示直接控制生成过程,提供了比传统文本到图像生成模型更高的灵活性和控制度。

MUMU应用场景

- 游戏设计:设计师可以使用MUMU快速生成游戏角色和环境的概念图,通过提供文本描述和参考图像来定制特定风格的场景和角色。

- 广告创意:广告制作人员可以利用MUMU将广告文案和视觉元素结合,生成吸引人的广告图像,以提高广告的视觉冲击力和创意表达。

- 社交媒体内容制作:社交媒体运营者可以借助MUMU根据热点话题或品牌调性生成独特的图像内容,用于吸引用户关注和提高互动。

- 教育和培训材料:教育工作者可以利用MUMU将抽象概念转化为直观的图像,帮助学生更好地理解和记忆复杂信息。

- 艺术创作辅助:艺术家可以使用MUMU探索不同的艺术风格和创作手法,将传统艺术作品与现代元素结合,创作出新颖的艺术作品。

-

个性化商品设计:商家可以利用MUMU根据消费者的个性化需求生成定制化的商品图案,如将用户上传的照片转换成特定风格的T恤印花。

MUMU项目入口

- arXiv技术论文:https://arxiv.org/pdf/2406.18790

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号