StreamingT2V:从文本生成一致、动态且可扩展的长视频

StreamingT2V简介

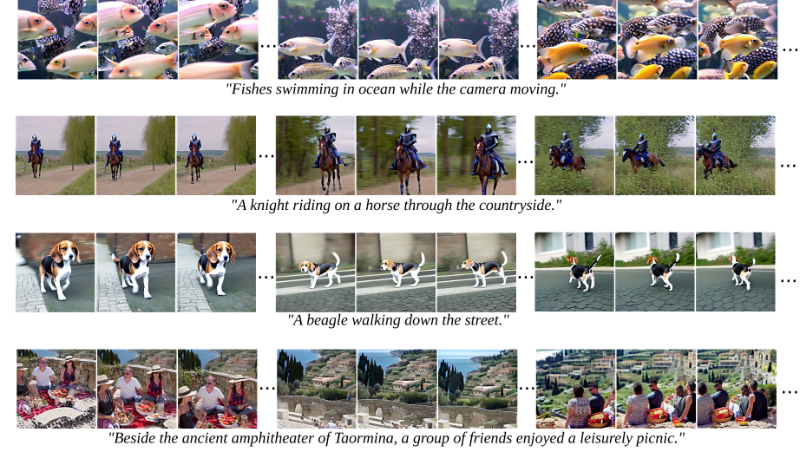

StreamingT2V是由Picsart AI Research团队开发的一项创新技术,它通过先进的自回归方法,能够将文本描述转换成具有丰富动态效果和时间连贯性的长视频。这项技术通过条件注意力模块(CAM)、外观保持模块(APM)和随机混合方法,确保了视频在扩展至数百帧以上时,依然能维持高质量的视觉效果和与文本描述的紧密对应。不同于传统方法,StreamingT2V能有效避免视频生成过程中的停滞现象,为广告制作、故事叙述等实际应用场景提供了强大的技术支持。

StreamingT2V主要功能

- 长视频生成:能够从文本描述生成长达数百帧的视频,远超传统方法通常生成的短视频长度。

- 时间连贯性:在整个视频序列中保持动态的连贯性,避免出现不自然的跳跃或重复。

- 高帧质量:维持高帧级别的图像质量,确保视频在长时间段内保持清晰和细节丰富。

- 文本对齐:生成的视频内容与输入的文本描述高度对齐,确保内容的一致性。

- 动态丰富:生成的视频具有丰富的动态效果,避免了长时间视频中常见的停滞现象。

StreamingT2V技术原理

- 条件注意力模块 (CAM):

- 利用注意力机制将当前帧的生成与前一片段的特征相结合,确保视频片段间的平滑过渡。

- 通过短期记忆块,关注前一片段中的关键帧,实现细节和动态的连续性。

- 外观保持模块 (APM):

- 从视频的第一个片段提取高级场景和对象特征,并通过长期记忆块保持这些特征,防止视频生成过程中对象或场景特征的丢失。

- 通过锚帧信息,在整个视频生成过程中维持一致的对象和场景外观。

- 随机混合方法:

- 在视频增强过程中,通过随机混合重叠片段的方式,实现连续片段间的无缝过渡。

- 通过共享噪声和随机选择混合比例,减少片段间的不一致性,提高视频的整体流畅度。

- 自回归生成:

- 采用自回归方法逐步生成视频的每一帧,允许模型在每一步都考虑到之前所有帧的信息,从而提高生成质量。

- 通过逐步添加噪声并逐步去噪的方式,模拟视频内容的逐步构建过程。

- 视频增强:

- 利用高分辨率的文本到视频模型对生成的视频片段进行增强,提高分辨率和质量。

- 通过重叠处理和随机混合技术,确保增强后的视频片段在合并时保持自然和连贯。

StreamingT2V应用场景

- 电影和视频制作:用于生成电影预告片、特效场景或故事叙述视频,减少实际拍摄成本和时间。

- 广告业:创造吸引人的广告视频,通过动态视觉效果和文本描述的紧密结合来吸引观众。

- 社交媒体内容创作:帮助内容创作者生成与热点话题或品牌推广相关的视频,增加用户参与度。

- 教育和培训:制作教育视频,如模拟实验过程或历史事件重现,提供生动的教学材料。

- 游戏开发:用于生成游戏内过场动画或宣传视频,提升游戏的吸引力和叙事深度。

- 虚拟旅游和模拟:创建虚拟旅游体验视频,让用户通过视频感受不同地点的风光和文化。

StreamingT2V项目入口

- 官方项目主页:https://streamingt2v.github.io/

- GitHub代码库:https://github.com/Picsart-AI-Research/StreamingT2V

- arXiv研究论文:https://arxiv.org/abs/2403.14773

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备44011102483711号

粤公网安备44011102483711号